某客户 K1 Power E880C对FC#EN1D 4端口 16Gb FC HBA卡(LP PCIe3) 的支持验证

一、 客户现状及痛点分析

某客户所采用的 K1 Power E880C 服务器 I/O 配置为四口 8GB 光纤通道卡 4;四口万兆以太网卡 8 ;磁盘扩展柜 *2 。

从 2018 年起,该客户采用 K1 Power E880C 服务器承载其关键业务系统。

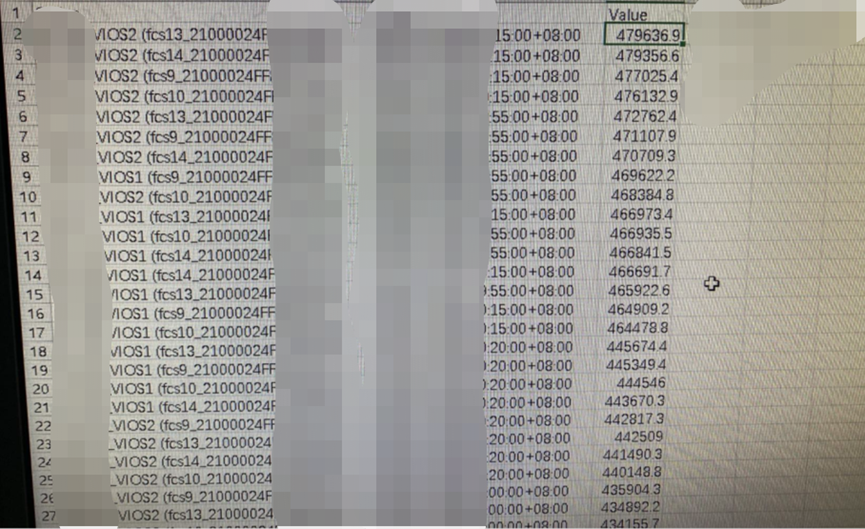

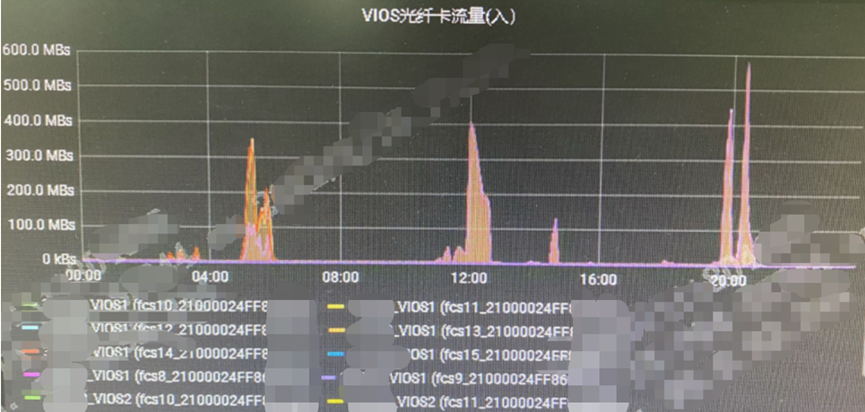

随着该客户业务的高速发展, K1 Power E880C 服务器的四口 8Gbps 光纤通道卡逐渐无法满足业务系统的性能需求。我们通过该客户的性能监控系统收集了以下日常工作负载时的性能数据:

K1 Power E880C VIOS光纤流量: 470MB/s

K1 Power E880C VIOS光纤流量: 580MB/s

K1 Power E880C VIOS光纤流量: 880MB/s

而 8Gbps 光纤卡的单口理论带宽为 1GB/s ,实际带宽则为 800MB/s 。

由此可见,在正常业务负载的情况下,采用四口 8GBps 光纤卡的 K1 Power E880C 服务器的 IO 性能基本可以满足该客户关键业务系统的带宽需求。但如果出现业务尖峰的情况下,可能无法完全满足该客户关键业务系统的带宽需求。

二、 K1 Power E880C 如何扩容光纤卡的性能以满足客户的需求?

1/ 采用 16Gbps 光纤卡?

POWER8 系列服务器仅支持:

- (#EN0A) - PCIe3 16Gb 2-port Fibre Channel Adapter

- (#EN0B) - PCIe3 LP 16Gb 2-port Fibre Channel Adapter

而一张双口 16Gbps 光纤卡与该客户所采用的四口 8Gbps 光纤卡的单卡理论总带宽均为 32Gbps 。因此,无法通过更换双口 16Gbps 光纤卡来满足该客户的需求。

2/ 通过增加 K1 Power E880C 服务器的光纤卡?

该客户一台 T42 机柜已经上下部署两台 K1 Power E880C 服务器,同机柜也无足够的空间安装新增的 PCIe I/O 扩展柜。

3/ 双 VIOS 采用 SAN boot 的方式,从而减少 4 张用于连接磁盘扩展柜的 SAS 卡 (客户建议)

K1 Power E880C 服务器通常会配置冗余的 SAS 卡并连接冗余的磁盘扩展柜以用于安装本地磁盘,这些本地磁盘将分配至 VIOS 分区用于安装 VIOS 系统。通过减少 4 张用于连接磁盘扩展柜的 SAS 卡以新增 4 张四口 8Gbps 光纤卡,双 VIOS 则采用 SAN boot 的方式。

但根据红皮书 PowerVM Best Practices 的建议:

The best practice for booting a Virtual I/O Server is to use internal disks rather than external SAN storage , if the server architecture and available hardware allows. The following list provides reasons for booting from internal disks:

- The Virtual I/O Server does not require specific multipathing software to support the internal booting disks. This configuration helps when you perform maintenance, migration, and update tasks.

- The Virtual I/O Server does not need to share Fibre Channel adapters with virtual I/O clients, which helps if a Fibre Channel adapter replacement is required.

- The virtual I/O clients might have issues with the virtual SCSI disks presented by the Virtual I/O Server that is backed by SAN storage. If so, the troubleshooting can be performed from the Virtual I/O Server.

- We do not recommend the allocation of logical volume backing devices for virtual I/O clients in the rootvg of the Virtual I/O Server.

- The SAN design and management is less critical.

- Access to the dump device is simplified.

以及业界较少案例采用 VIOS 系统盘采用 SAN boot 的虚拟化架构,再者该客户很可能无足够的时间进行较为完整的 SAN boot 测试。最后,建议该客户继续沿用 VIOS 系统盘采用本地盘的虚拟化架构,也是当前业界最佳实践的虚拟化架构。

4/ 同一光纤端口部署 vSCSI 和 NPIV 两种技术(客户建议)

某客户当前一张四口 8Gbps 光纤卡的端口使用方式如下:

- T1口用于 vSCSI for VIOC rootvg

- T2 口用于 NPIV for VIOC datavg or data LUN

- T3 口用于 NPIV for VIOC datavg or data LUN

- T4 口用于 NPIV for VIOC datavg or data LUN

由于 T1 口仅通过 vSCSI 技术承载 VIOC rootvg 的数据流量, I/O 负载理论上相对较轻,客户建议优化架构如下:

- T1口用于 vSCSI for VIOC rootvg + NPIV for VIOC datavg or data LUN

- T2 口用于 NPIV for VIOC datavg or data LUN

- T3 口用于 NPIV for VIOC datavg or data LUN

- T4 口用于 NPIV for VIOC datavg or data LUN

为了避免当 T1 口的 VIOC datavg or data LUN 数据流量过大而影响同一端口的 vSCSI for VIOC rootvg ,不建议采用此架构用于关键业务系统。因为当故障发生时,会对 VIOC 的系统盘 rootvg 也造成影响,不便故障根因的进一步分析。

5/ RPQ 8A2419-8284 - PCIE3 16GB 4PORT ADPTR POWR8

This i-Listed RPQ delivers one PCIe3 16Gb 4-port Fibre Channel Adapter for low profile PCIe slots (equivalent to FC #EN1D) per machine-type-model for each system its ordered against.

通过官方发布的 RPQ 8A2419-8284 - PCIE3 16GB 4PORT ADPTR POWR8 ,使得 K1 Power E880C 服务器可以配置并使用原本不支持的四口 16Gbps 光纤卡 FC#EN1D-PCIe3 16Gb 4-port Fibre Channel Adapter 。

该 RPQ 明确指出所适用的机型、操作系统版本、板卡的建议安装位置及如何下单等等,详细信息可参考以下链接:

https://www.ibm.com/common/ssi/ShowDoc.wss?docURL=/common/ssi/rep_rp/9/ENUS8A2419/index.html&;lang=en&request_locale=en

三、 测试及验证

在浪潮商用机器实验室根据该客户的生产环境部署测试环境以验证 RPQ 8A2419-8284 - PCIE3 16GB 4PORT ADPTR POWR8 ,完成 兼容性测试、功能性测试及基本的数据库压测。

1/ 环境描述

某客户客户的生产环境的具体环境如下:

- 服务器型号及配置: 9080-MHE , 64C , 2CEC

- 服务器微码版本为 IBM, FW860.A0(SC860_231)

每 CEC 安装两张光纤卡(合计四张光纤卡),均部署在 C1 和 C6 槽位, C1 槽位的一组光纤卡分配至 VIOS1 , C6 槽位的一组光纤卡分配至 VIOS2 。

客户四口光纤卡的使用规则如下所示:- T1 -- vSCSI for VIOC rootvg

- T2 -- NPIV for VIOC data LUN

- T3 -- NPIV for VIOC data LUN

- T4 -- NPIV for VIOC data LUN

- 服务器的 VIOS 版本为: 3.1.X.XX

- 服务器的 VIOC 版本为: 7200-XX-XX-XXXX 。

- 服务器的 VIOC 所采用数据库版本为: Oracle 19.XX

浪潮商用机器实验室环境与某客户生产环境差异性如下:

服务器型号及配置: 9119-MME , 2CEC

- 同在 RPQ 8A2419-8284 - PCIE3 16GB 4PORT ADPTR POWR8 支持清单

服务器微码版本为 IBM, FW860.42 (SC860_138)

- 低于某客户所采用的 FW 版本。当前测试使用的版本为 860.42 是符合 RPQ 中要求的,使用此版本测试对测试结论的判断影响不大。

- FC#EN1D PCIe3 16Gb 4-port Fibre Channel Adapter 微码版本:00012000040025700030

2/ 兼容性及功能性测试

- 完成操作系统的安装和信息检查, OS 无错误日志产生。

- 完成 ASMI 界面日志的检查,无错误信息产生。

- 完成 ASM 下 HBA 卡链路信息检查,链路信息正常。

- 完成 HMC 下 HBA 卡信息显示检查, HMC 下的信息显示正常。

- AIX OS 下 HBA 卡信息检查、光功率数据检查、 Diag 测试无错误。

- HBA 卡各端口 HTX 压力测试 18 小时左右无错误;手动执行 3 次 DC 和 reboot 稳定性测试无异常。

3/ 数据库基本性能压测

- K1 Power E880C 上部署了 Oracle RAC 环境( 19c ),安装过程无异常

- 存储 SSD LUN 使用 NPIV 方式挂载至 VIOC

- 数据库内初步执行 IO 校准测试,情况如下:

测试脚本:

SQL> set serveroutput on; SQL> DECLARE at INTEGER; iops INTEGER; mbps INTEGER; BEGIN DBMS_RESOURCE_MANAGER.CALIBRATE_IO (16, 10, iops, mbps, lat); DBMS_OUTPUT.PUT_LINE ('max_iops = ' || iops); DBMS_OUTPUT.PUT_LINE ('latency? = ' || lat); dbms_output.put_line('max_mbps = ' || mbps); end; /测试结果:

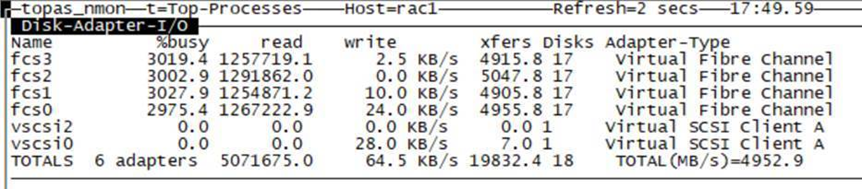

- max_iops = 263369

- latency = .888

- max_mbps = 4405 (单位 MB )

- 光纤卡吞吐量: ( 由于测试环境的存储性能受限,完成基本的性能测试 )

四、 结论

通过官方发布的 RPQ 8A2419-8284 - PCIE3 16GB 4PORT ADPTR POWR8 ,可以使得 K1 Power E880C 服务器配置并正常使用原本不支持的四口 16Gbps 光纤卡 FC#EN1D-PCIe3 16Gb 4-port Fibre Channel Adapter 。

该客户可以在不修改现有 PowerVM 业界最佳实践架构的基础下,对现有 K1 Power E880C 所采用的四口 8Gbps 光纤卡升级为四口 16Gbps 光纤卡,实现性能的翻倍,确保关键业务系统的高效且稳定的运行。

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞1作者其他文章

评论 0 · 赞 2

评论 0 · 赞 0

评论 0 · 赞 0

评论 0 · 赞 1

评论 0 · 赞 0

添加新评论0 条评论