Hadoop安全之Kerberos总结

对于Hadoop的安全,现在业界都给予了关注,HDP、CDH都通过收购安全公司来加强其套件的安全性。

Rhino项目

在Rhino项目下列出了希望在Hadoop中实现的安全特性。

在身份验证方面,实现一个不依赖外部源的新的内部系统,同时提供更好的单点登录功能。授权机制方面,可以跨越许多Hadoop应用程序,从批处理的MapReduce到HBase数据库。

Knox项目

来自Hortonworks的几位工程师今年一直活跃在某个名为Knox的孵化器项目。Hortonworks的企业战略副总裁Shaun Connolly解释说,这个项目就像在Hadoop集群中的服务器周围构造一个大的虚拟围栏,对于可用的Hadoop服务只有一个安全网关可以进入。

除此之外还有CDH的Sentry项目。

我认为要构建企业Hadoop安全的平台需要考虑以下问题:

1.认证机制

需要具备提供单一节点和已存在的企业鉴权和授权管理系统的认证

2.授权机制

加强对敏感数据的细粒度的访问控制和基于角色的授权

3.访问控制

需要在应用层控制每个用户的集群处理容量和数据集的操作

4.数据的置乱和加密

需要部署合适的加密和置乱算法,确保敏感的数据只对授权的用户提供访问

5.网络边界设备的安全

部署网络边界设备保障数据进出集群的安全。设计和实现合适的大数据平台隔离方案,防火墙策略控预防非授权访问。

6.系统安全

加强对操作系统安全的控制,即使跟踪系统应用程序的安全。及时打安全补丁。

7.设备安全

加强设备的物理巡检和数据中心的安全。

8.设备和事件监控

需要对数据平台的重点操作进行监控和审计,报告各种发生在数据平台的敏感活动。

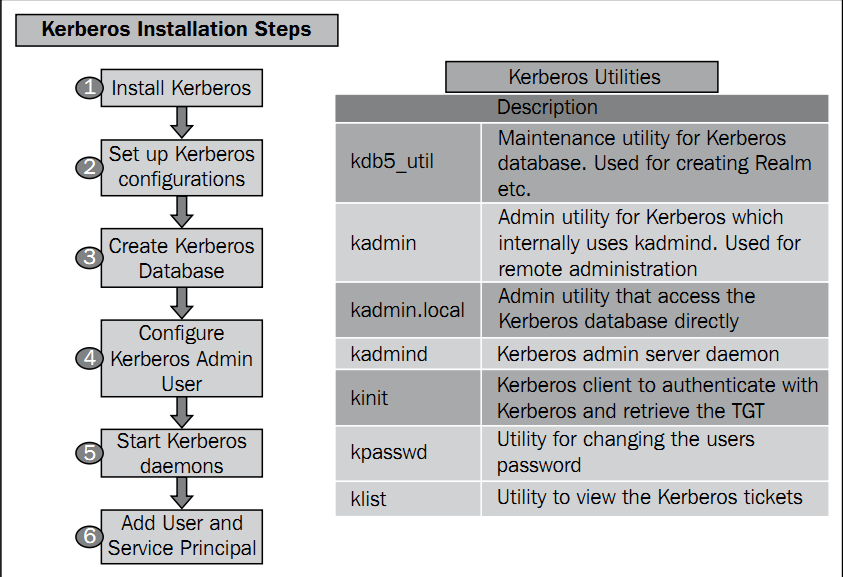

现在就对认证过程做个小结,对于Hadoop的认证和单点登入(SSO)寄希望于。整个安装过程可以用如下流程表示。

分别为1.安装Kerberos服务程序;2.设置Kerberos配置文件;3.创建Kerberos数据库;4.配置Kerberos管理员用户;5.启动Kerberos进程;6.添加认证用户和服务

每个阶段的详细介绍敬请期待。

利用Kerberos对Hadoop进行授权。可以分为以下步骤

步骤依次为:1.创建HDFS、MapRed和YARN的认证;2. 创建HDFS、MapRed和YARN的密钥文件;3.分发密钥文件到相应节点;4.设立合适和密钥文件权限;5.更新Hadoop的配置;6.设置安全的DataNode和TaskTracker。

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞0作者其他文章

评论 1 · 赞 2

评论 0 · 赞 1

评论 0 · 赞 0

评论 0 · 赞 3

评论 0 · 赞 0

添加新评论0 条评论