从双活演进到3DC架构的验证和实践

【摘要】

本文以银行存储灾备需求特点的规划建设为背景,通过对自主创新存储容灾方案全流程测试,银行实现存储容灾方案的全面论证。基于我行业务需求特点、业务连续性和厂商产品成熟度等方面的综合考量,本实践最终选择了华为高端全闪存存储Dorado18500 V6组成双活+异步复制环形3DC容灾方案进行充分测试验证。从功能测试、高可用测试和性能测试三个方面验证了容灾方案的先进性,对于金融行业未来业务发展,提供了技术支撑力量。

全文共分三个部分:第一篇 需求分析与产品选型;第二篇 技术路线与测试方案设计;第三篇 测试结果与效果。

第一篇 需求分析与产品选型

本篇旨在为从双活演进到3DC架构的验证和实践明确需求和相应的产品选型,从监管趋严的大背景出发,审视我行连续性架构建设的国产化实践,选择华为OceanStor Dorado全闪高端存储进行双活业务部署,并平滑升级到3DC架构的方案完善我行业务连续性和灾备保护的技术储备。

1 项目背景

随着银行信息化程度在不断提高与完善,信息系统在金融行业的关键业务中承担的角色越来越重要,保证业务连续性是信息系统建设的关键,业务系统的连续性和灾难保护的重要性也越来越突出。同时金融监管体制的不断健全,同城灾备、两地三中心以及多数据中心正在成为金融机构保障业务连续性的标配。在《金融科技发展规划(2022-2025年)》(银发【2021】335号)文中,提及多活数据中心的要求如下:按照系统、机房、城市等容灾目标,积极采用多活冗余技术构建高可靠、多层级容灾体系,满足日常生产、同城灾备、异地容灾、极端条件能力保全等需求,提升金融数据中心纵深防御能力,逐步形成高可用数据中心。

首先,对于银行的生产业务系统来说,稳定可靠是第一位的,业务不能中断,数据不能丢失,必须提供7×24小时连续业务;第二,由于全闪存的普惠,特别是国内高端全闪存厂商的崛起,使得全闪存的普及进程进一步加快,可以使银行机构快速技术迭代,向更为绿色、节能、高效、稳定的全闪数据中心演进。第三,监管趋严,故障后处罚严格,因此也对银行的业务连续性提出了高要求,对RTO和RPO的追求也越来越趋于极限0。

因此,我行着手部署双活到3DC的业务测试,为我行未来打造 “多地多中心多活”基础支撑体系提供技术储备。

2 需求分析

目前我行连续性架构建设还存在一定的不足,主要表现在同城和异地存储灾备体系高可用架构模式单一,即基于EMC SRDF的架构实现同城双活或灾备。为满足安全可控要求,我行急需做好第二家存储两地三中心容灾解决方案的技术可行性分析和技术储备。

3 建设目标

通过本次POC测试,希望验证3DC备份容灾建设目标的可行性,满足业务不能中断,数据不能丢失,提供7×24小时连续业务的目标,逐步形成高可用数据中心。:

1) 生产中心业务系统逐步在同城建设应用级容灾系统,一般灾难条件下实现同城业务接管。

2) 同城灾备中心到异地灾备中心实现数据的异地复制保存,分批完成异地灾备中心的业务系统容灾。

4 产品选型

针对关键系统存储的选型,需要做多方面的考虑。结合银行多年的使用情况和目前的行业趋势,总结如下关键点:

4.1 产品设备可靠稳定

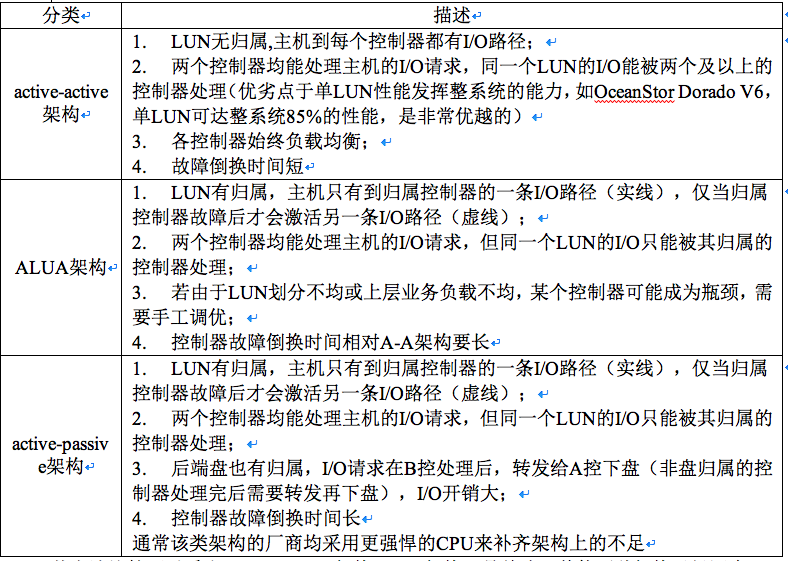

首先,产品的可靠稳定,第一要从架构本身来保证。业界常见的存储架构有active-active架构、ALUA架构、active-passive架构,区别如下:

从上述比较可以看出,active-active架构(A-A架构)是首选,其他两种架构已经逐步淘汰。

4.2 产品设备性能

从IDE、SATA到SAS,硬件接口协议发展经历了交替革新,性能也逐步提升。但总体来看,这些硬件协议大都为通用接口协议,是从支持机械硬盘演进为支持固态硬盘的,性能上并没有就固态硬盘颗粒高速读写能力做出太多优化。直到PCIe SSD的出现,SSD性能得以进一步释放。PCI-Express(peripheral component interconnect express)是一种高速串行计算机扩展总线标准。PCIe属于高速串行点对点双通道高带宽传输,所连接的设备分配独享通道带宽,不共享总线带宽,主要支持主动电源管理,错误报告,端对端的可靠性传输,热插拔以及服务质量(QOS)等功能。PCIe的主要优势在于其减少延迟的能力。PCIe设备和PCIe总线直接相连,使缓存和数据更接近CPU。但彼时的PCIe SSD却做不到拿来即用,不同的操作系统、不同的应用场景都需要PCIe SSD给出相应的驱动、配置、维护以及升级方案。PCIe SSD作为数据中心的一个存储组件,借助标准化构筑完整的生态是必然趋势,而NVMe正是在这样一个背景下诞生并成为了PCIe SSD开启闪存时代的引爆点。

PCIe SSD消除了传统存储协议的开销,并且如下测试反映出IOPS远远高于SAS和SATA SSD。

NVMe标准化组织官方,SNIA、PCI-SIG、Gartner、IDC等标准化组织和分析机构也同样在推动NVMe发展。从磁盘等产品的发展历程,我们可以预测市场将充分验证NVMe的生命力和优势。

从上述比较可以得出结论:考虑到成本情况下,可以选择混合存储;但是一旦选择全闪存,由于NVMe SSD\\SAS SSD\\ SATA SSD 成本接近,首选NVMe SSD。

4.3 组网架构和演进能力

上一代存储容量相对较小、可扩展性较差,因此对一个数据中心的发展而言需要配置的存储数量会逐渐增多,而由于分批采购会出现多家不同品牌中标,单个数据中心可能会大量异构品牌的存储。在这种情况下,要想实现存储双活,必须依赖Vplex、SVC等存储网关,利用存储网关兼容异构存储、方便异构存储之间数据迁移、方便扩容等优点。

常见的SAN+NAS双活有四类:active-active双活、A-P双活、Cluster双活、网关双活:

云原生发展如火如荼,以容器、微服务、DevOps等技术为基础建立的一套云技术产品体系对存储也提出更高的要求。

从上述比较可以得出结论:免网关A-A双活,减少了故障点,整个组网架构更加简单,更有利于架构演进。此外,选型要关注前沿技术需求,比如云原生应用开发。

4.4 安全自主可控

俄罗斯-乌克兰战争中,俄罗斯受到了以美国为首的西方国家的疯狂制裁;欧洲截止写文章时,已经发起十轮制裁。在科技领域,以 Oracle、谷歌、苹果、微软、英特尔、日立、IBM、亚马逊、戴尔为首的20多家科技巨头相继对俄罗斯出手围堵,甚至连开源社区,也进行封锁;美国也对开源代码漏洞等发布新规。

在此国际环境下,安全自主可控,就是不是简简单单看某颗芯片,而是全栈的自主可控。细到存储产品,主要考察:芯片、操作系统、存储系统软件、SSD控制器、SSD产品等等。

4.5 技术支持与运营维护能力

存储选型时,技术支持和运营维护能力,也是重点考虑指标。采购和交付只是存储生命周期的很小一部分,交付后的运维才是运维人员最主要的工作。特别是对运维能力不强的中小银行来说,存储厂商自身的研发实力以及后期服务能力,是否有未来数年的规划支撑客户的业务需求变化,是否有软硬件的研发能力,在遇到个性化需求时或需求变化时能够有跟踪变化的能力,是否有本地的服务力量,这些都需要考查和了解。

在众多厂家中,华为OceanStor高端存储具备业界唯一的前后端全互联架构,具有“软件全均衡,硬件全互联”的技术特点:

1)软件全均衡:华为OceanStor高端存储通过前端接口卡实现业务均衡下发。前端业务进入存储系统后,前端接口卡通过业务数据指纹,通过DHT算法将不同指纹属性的业务均衡下发给四个控制器,保持所有控制器上的业务量均衡,充分发挥控制器能力,避免业务分配不均带来的性能瓶颈。数据通过控制器后,经RAID2.0算法,打散存储在所有后端硬盘上。

2)硬件全互联:华为OceanStor高端存储实现软件全均衡的基础是硬件全互联。前端采用共享接口卡,实现与4个控制器互联,4个控制器之间也互相连接,后端同样采用共享接口卡,4个控制器通过它共同连接后端硬盘。实际上,在我们的画面上未表现出来的,我们两个引擎的后端接口卡可以连接到同一个硬盘框上,也就是说可以由两个引擎共8个控制器共同访问同一个硬盘阵列。硬件全互联的连线,均承载在这样一块无源背板上,它由多层结构压制,只具有极少数的元器件和电路连线,可靠性极高。

华为OceanStor高端存储通过“软件全均衡,硬件全互联”的全互联架构,在可靠性,吞吐量和时延上均有很好的表现。

高吞吐:由于业务被前端接口卡均衡下发给了4个控制器,避免了业务阻塞在某一个控制器上造成性能瓶颈,充分利用了计算资源,因此华为OceanStor高端存储能实现业界第一的最高2100万IOPS;

可靠性:华为OceanStor高端存储硬件全互联架构,从架构上保证了业务的高可靠。首先,前端共享卡与4控互联,业务在前端接口卡进行分发,避免了控制器IP地址漂移等过程,使得控制器损坏业务无中断、前端无感知;其次,双引擎八控共同接管一块硬盘阵列,使得业务具有最高允许控制器八坏七的容错能力;数据在底层硬盘打散均衡存储,最大程度保护了数据的安全可靠。

低时延:华为OceanStor高端存储通过端到端NVMe加速设计,达到了业界最低的端到端0.05ms时延。

华为OceanStor高端存储CPU采用鲲鹏920,操作系统为欧拉操作系统,均为国产自主产品。SAN&NAS一体化AA双活,应对最苛刻的企业可靠性需求。

免网关:减少故障节点,简化管理

A-A 双活:两站点间负载均衡, RPO=0 & RTO≈0,ALL IP双活性能相比传统IP方案提升50%

业界唯一的NAS A-A双活:支持三层网络双活

平滑扩展到3DC,提供更高级别可靠性

支持串行/并行/环形3DC组网(SAN),应对最苛刻的企业可靠性需求.

华为OceanStor高端存储, 提供标准对接:支持对接业界领先的容器管理平台;专业支持:一流技术支持,解决复杂性和开发文化难题;CDR专业容器灾备管理,应用级备份恢复;备份省:应用粒度备份恢复,免备份软件,节省TCO;CSI全面支持,高效易用:CSI标准接口对接,存储资源按需发放,简单易用;发放快:业务批量发放速度领先业界。30%。

从2021年开始,我行致力推动信息技术应用创新,提升自主可控能力,加快国产化产品的应用适配等工作。2021年规模采购的华为基于鲲鹏芯片的中高端存储,经过两年的稳定运行,充分证实了其设备的稳定可靠。基于以上考虑选择华为OceanStor Dorado全闪高端存储进行双活业务部署,并平滑升级到3DC架构。

第二篇 技术路线与测试方案设计

本篇承自第一篇需求分析与产品选型确定的华为OceanStor Dorado全闪高端存储进行双活业务部署,并平滑升级到3DC架构的要求,详细的梳理了3DC的不同方案架构,明确了测试内容包括双活、3DC功能测试和性能测试,并确定了测试硬件与软件配置。

5 方案选型

两地三中心为用户提供了灵活的组网方式,可根据现有网络情况和对容灾备份RPO及RTO的要求来初步选择组网方式。不同组网方式应用场景对比如下表所示。

除此之外,还有以下几个因素需要考虑:

对A站点的性能影响:并联组网中,由于A站点存储系统承担了两个远程复制数据同步的任务,因此对生产中心存储系统性能影响大于级联组网。

同城站点的故障影响:级联组网中,由于异地容灾的远程复制依赖于B站点,且两地三中心不能支持星型组网(即三个存储系统两两之间互为备份),因此,当B站点发生故障后,A站点将失去所有备份站点。而并联组网中,即使同城B站点发生故障,也不影响A-C之间的数据容灾备份,避免了B站点成为数据备份的单点故障节点。

从双活到环形3DC平滑演进:

图中,LUN_bb既为双活的远端LUN,又为BC远程复制的主端LUN。LUN_cc为两个远程复制的共用从LUN。

环形3DC创建完成后的初始同步:

手动启动或者由系统自动启动LUN_aa到LUN_bb的初始同步。当LUN_bb数据状态为“完整” 时,手动启动或者由系统自动启动从LUN_bb到LUN_cc的同步,将LUN_bb中的数据完全同步到LUN_cc中。

为了保证C存储系统备份数据的可用性,3DC对主机数据的处理机制如下:

- 主机双写数据到LUN_aa和LUN_bb。

- 当B->C远程复制的同步周期到来时,系统首先检查双活的远端LUN (LUN_bb)数据状态,当数据状态为“完整”时,生成LUN_bb在此时间点的快照数据t1_snap。

- 存储系统C生成LUN_cc在此时间点的快照数据t2_snap。

- 后台启动由LUN_bb的快照数据t1_snap到LUN_cc的周期性同步。

当B站点发生故障时,可以启用A、C之间的远程复制(此时,B、C之间远程复制切换为备用)使异地数据保护不受影响。A、C之间的数据复制原理同上。

经过现网情况评估:最终采用双活+异步复制环形3DC容灾解决方案进行组网。

6 测试方案设计

本次测试旨在通过进行华为同城双活和3DC架构的功能和性能测试,验证RPO和RTO是否满足业务连续性要求,为我行灾备系统建设提供可用依据。

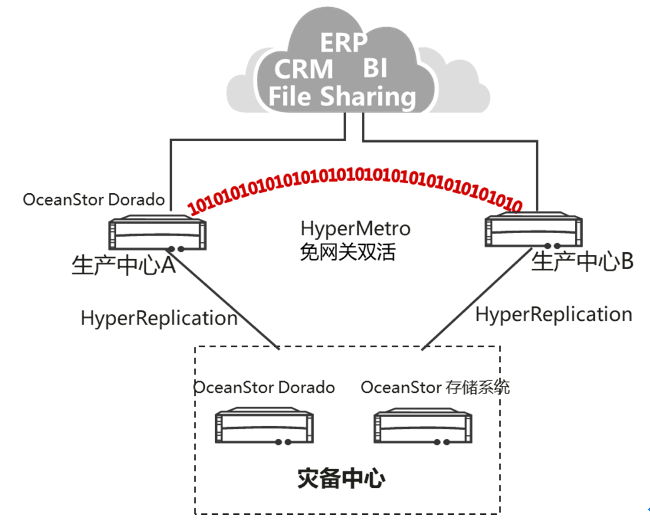

6.1 两地三中心架构方案

下图是我行使用三套华为高端存储设备在三个数据中心之间构建两地三中心架构图:

下文A城市DC1简称DC1;A城市DC2简称DC2,B城市DC3简称DC3。

生产中心(A城市DC1和A城市DC2)以及异地灾备中心(B城市DC3)组成存储双活+异步复制的环形3DC容灾解决方案组网。

双活业务平面(DC1和DC2)

生产中心(DC1和DC2)为存储双活,DC1为优先站点,复制链路为FC链路,采用波分设备进行拉远;

远程复制平面(A城市和B城市)

DC2和DC3、DC1和DC3之间复制链路为IP链路,DC1和DC3之间为主用复制链路,DC2和DC3为备用复制链路。

6.2 测试方案

本次测试范围包括同城双活和3DC的系统功能验证,可靠性验证,业务切换可靠性验证以及单存储、双活存储和3DC架构性能测试。具体设计如下:

双活测试设计:

DC1和DC2机房分别使用一台华为高端全闪存OceanStor Dorado 18500 V6组成双活架构。华为OceanStor Dorado 18500 V6高端全闪存存储采用HyperMetro特性实现免网关的存储层AA双活,两套阵列组成双活集群,减少VPLEX、SVC等存储网关设备故障点,避免存储虚拟化网关的I/O性能瓶颈,同时通过FastWrite功能,将标准的1个写I/O 2次往返优化为1次往返,提升双活存储的写性能,实现本地高可靠。基于两套存储阵列实现Active-Active双活,两端阵列的双活LUN数据实时同步,且双端能够同时处理应用服务器的I/O读写请求,面向应用服务器提供无差异的Active-Active并行访问能力。当任何一台存储阵列故障时,业务自动无缝切换到对端存储访问,业务访问不中断。

性能测试设计:

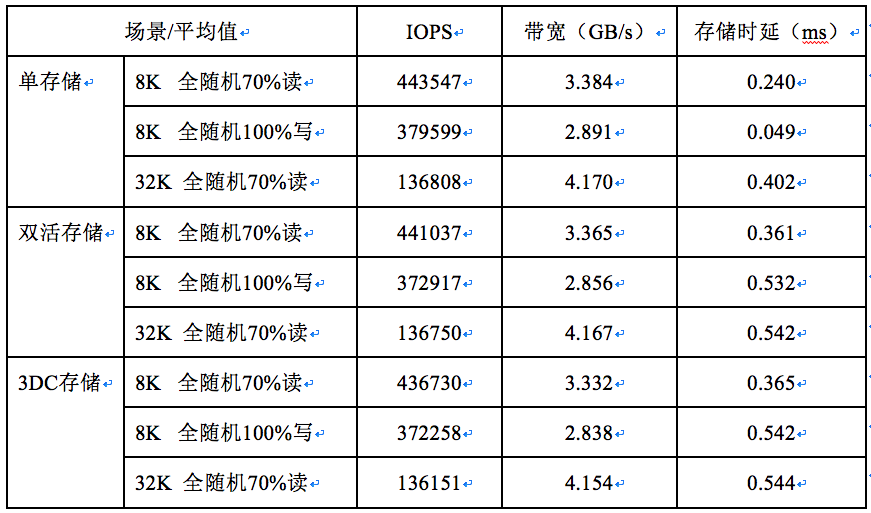

针对单存储、双活存储和3DC架构三种架构,分别测试“8K IO+全随机+70%读”、“8K IO+全随机+100%写”、“32K IO+ 全随机+70%读”的三种业务场景。

3DC测试设计:

测试3DC容灾方案基本功能,测试链路故障,测试切换和回切。

7 业务上线前测试

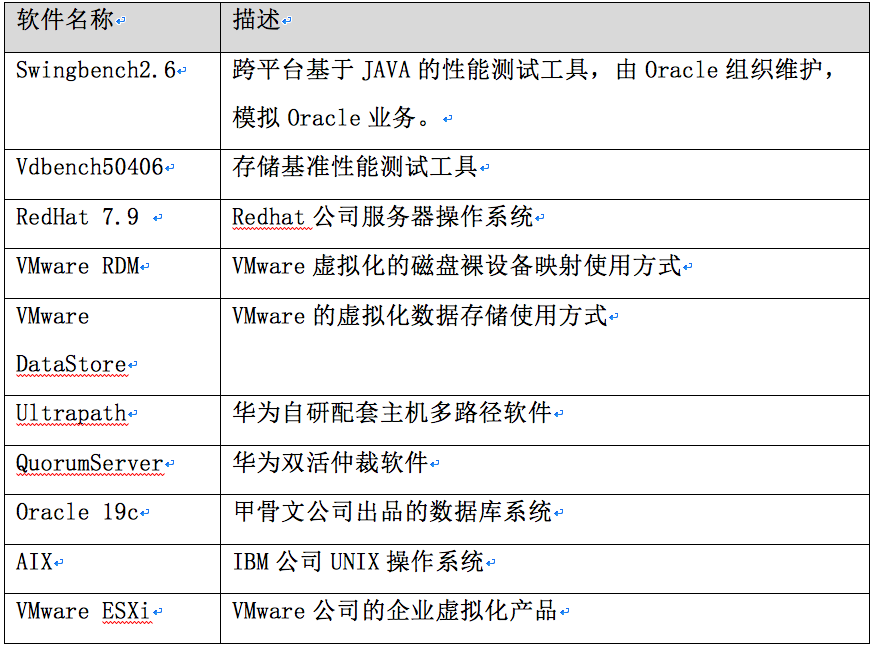

7.1 测试硬件与软件配置

第三篇 测试结果与效果

本篇梳理了第二篇技术路线与测试方案设计制定的全面的测试结果,发现使用华为OceanStor Dorado全闪高端存储进行双活、3DC功能测试和性能测试均能达到预期效果,整体测试非常成功,验证了我行使用华为方案从双活演进到3DC架构的可行性。

8 测试用例及结果

8.1.1 同城双活测试用例:

同城双活系统功能验证,可靠性验证,业务切换可靠性验证结果如下:

8.1.2 双活和3dc性能测试:

针对单存储、双活存储和3DC架构三种架构的三种业务场景性能测试结果,记录在主机CPU达到100%或者HBA卡带宽到上限后的测试数据汇总如下:

根据测试结果,总结如下:

(1)单存储架构下,由于写IO直接写本存储cache,读IO需要从本端存储的磁盘读上来, 100%写场景下时延均比70%读(即30%写)场景的时延更小。

(2)在双活架构下,写IO需要双写到两台存储的cache,IO在双活复制FC链路来回增加了时延,而读IO只需要从本端存储的磁盘读上来,所以100%写场景下时延比70%读(即30%写)场景的时延更大。

(3)三种IO场景在单存储、双活存储、3DC架构下IO时延均依次增加。原因分别是:双活存储相对与单存储增加了双活两台存储之间复制链路的来回IO时延;3DC架构下,当业务压力较大时,由于有一台存储既要处理双活又要处理远程复制,性能较双活场景会降低。

Oracle 带事务性业务场景下,双活存储业务链路故障不影响业务运行:

DC1和DC2业务切换与回切(AIX+Oracle HA)正常:

8.1.3 环形3DC测试用例及结果

本次测试3DC的系统功能验证,可靠性验证,业务切换可靠性验证结果如下:

9 测试结论

- 系统功能验证、可靠性验证、业务切换可靠性验证,证明容灾技术成熟可靠,RPO和RTO均能满足业务述求。

- 华为高端存储A-A免网关双活架构的可靠性进行了充分验证:任何一套设备宕机均不影响上层业务系统运行;

- Oracle 带事务性业务场景下,默认超时时间为60秒;存储自身是15秒完成切换。本次测试发现I/O跌零时间最长约为25秒,不影响业务正常运行;

- 业务环境分:AIX+Oracle HA、VMware RDM、VMware DataStore、X86+Oracle,四个行里关键业务环境进行了充分测试;

- 灾备切换中:同时使用网页和命令行进行测试,对测试结果进行充分验证。存储多种故障下,业务均可以实现正常切换和回切;

- 稳定试运行:3DC环境下,系统已经稳定运行2个月。

10 总结

本次双活和3DC测试,从22年4月至22年9月,历经5月,项目进行了全面的测试,包括单台存储、双活存储以及3DC架构的功能测试、高可用测试和性能测试。本次测试意义重大。

1)、充分验证设备、系统、架构的可靠性:业务连续性容灾解决方案(两地三中心)解决方案通过存储复制技术,实现将存储上多个业务系统的生产数据自动复制到同城灾备中心和异地灾备中心。结合容灾管理系统,针对应用数据库,如Oracle,SQL Server,DB2,Exchange等进行集成实现容灾管理,当灾难发生时,确保可以快速在灾备站点一键式启动应用系统接管业务。

2)、提升灾备演练能力:在测试中,能够有效识别运维工具是否全面、多样,是否提供智能化工具、开发接口以及工具后续开发能力,以提高行方存储运维效率。同时,推动灾备管理和切换技术手段更加简便快捷,行方人员将积累相关经验,大大缩短了灾备切换的时间。

3)、锻炼人才,培养队伍:人才软实力是数字化转型的必要条件,在3DC业务投产过程中,行内人员和厂家驻场工程师深入参与项目建设,提升了对全闪存产品技术的理论认识及实操能力。

4)、支撑未来业务发展:通过3DC的测试验证和全闪存储、3DC业务的投产,支撑未来业务发展的同时也以我行“十四五”战略规划为指导意见,践行“多地多中心多活”技术的创新验证与应用。

5)、行内领先技术试验田:全闪存存储已经成为各家主流存储厂商的标准配置,同时结合控制器和硬盘框的NVMe技术应用,IOPS已经从传统机械硬盘存储的几万、十几万,上升到几百万级别,性能得到极大提升。本次测试使用NVME 全闪存,将充分验证其设备性能。与原有网关架构对比,新架构本地双活基于华为hyperMetro功能,带来的优点有:(1)减少网关故障点,提升可靠性;(2)无需网关转发,降低I/O时延;(3) 降低双活组网复杂度,便于维护。架构搭建复杂度大大降低,消除了传统的存储网关这一瓶颈的存在。后续计划使用NVMe over Fabrics(NOF+)技术后,实现了计算、网络以及全闪存存储全栈国产化的创新。该方案不仅可以获得和FC网络同样的IOPS处理能力,还可以在时延上大幅降低到原来的50%,同时整体的网络TCO降低65%。紧接着,该试验局点,将验证与华为公司联合创新的4DC多地多活技术。

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞12

添加新评论1 条评论

2023-06-14 14:58