存储架构技术发展演变30年(上)

【摘要】:随着信息技术的发展,数据已经成为企业的战略资源,如何存储数据以及如何利用数据也已成为企业科技部门研究的热点话题,尤其是伴随着近些年的互联网革命,数据存储世界也发生了翻天覆地的变化,出现了很多新的名词、新的产品、新的趋势等等。面对这些眼花缭乱的事务,如何抽丝剥茧抓住事务的本质其实是从事技术研究工作的首要任务。而对于分布式存储技术这个领域,我认为需要从纵向的存储技术发展脉络和横向的主流技术对比两个方面来深刻认识。

一、存储技术的原始阶段

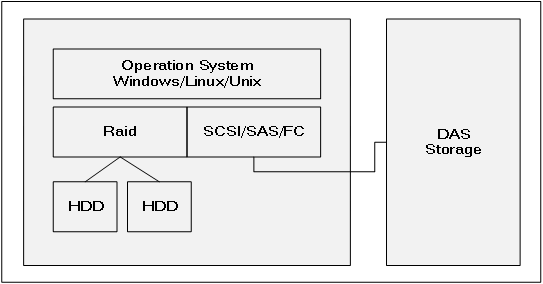

如果以具备独立存储设备为界限,我们暂且追溯到DAS存储的发展阶段,主要是90年代之前的周期。这个阶段的应用系统主要是单机业务系统,相互之间独立,所需存储的数据量也非常少。但是这个时候数据的安全性已经提升到一定高度,于是基于数据的安全性考虑,将业务数据独立,产生了DAS存储架构。

图1.1 DAS存储架构图

DAS(Direct-Attached Storage)

1.通过FC、SCSI、SAS等协议与主机相连接,提供存储服务;

2.DAS存储作为单独的存储平台,可以配置RAID冗余策略来保护数据;

DAS存储架构之前的没有独立存储平台的服务器IT架构相比较,解决了什么样的问题?

任何优势都是相对于特定的历史时期而言的,存储架构的优势也是站在特定的历史时期下来说的。在那个特定的历史时期下,它实现了服务器系统数据和业务数据的分离,相比较之前的服务器内部存储架构来讲,从数据的安全性、灵活性、扩展性方面都有了本质的提高。

1.安全性方面实现了系统数据和业务数据的隔离;

2.灵活性方面去掉了与服务器系统本身的耦合性;

3.扩展性上实现了从若干块服务器机械硬盘的容量到一组甚至几组硬盘的容量规模。

DAS存储架构在自己的时代又经历了哪些进化?

在这个特定的时代,无论DAS存储架构如何进化,都只是量的变化,并没有发生质的改变。例如连接协议的改变,由最初的一条SCSI线逐渐进化为可以冗余的FC光纤线,结合上多路径聚合技术的应用,实现了物理链路的高可用;例如DAS存储产品本身的最大容量由最初的单存储柜容量变成了多柜容量;例如如DAS存储的冗余策略也从简单的RAID1、RAID1+0变为了更丰富的冗余策略;例如数据分布策略逐渐优化到更小粒度的平均分布策略。

二、SAN&NAS共存的发展阶段

伴随着1995年博科(Brocade)公司的诞生,存储区域网络(SAN)的概念走进存储世界,1999年EMC发布第一款支持SAN存储区域网络的存储产品。从此之后,SAN存储便成为企业存储的主导。

80年代,Novell提出了Netware操作系统和NCP(网络核心协议);Sun推出了针对Unix系统的网络文件系统(NFS)协议。1993年,NetApp推出了一个NAS设备。1996年,NetApp又推出了能够同时具备支持CIFS&NFS协议的存储设备,也就是企业级的网络附加存储(NAS)存储设备。

图1.1 SAN存储架构图

SAN(Storage Aread Network)Storage

- 通过FC协议与主机的HBA卡相连接,提供数据存储服务;

- 可以提供Block存储载体;

- 可以实现多链路高性能及高可用读写的数据存储服务;

- 可以实现远距离的数据存储服务;

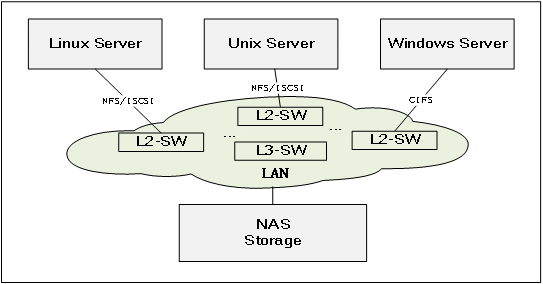

图1.1 NAS存储架构图

NAS(Network-Attached Storage)

- 通过以太网络协议与主机相连接,提供数据存储服务;

- 只能提供文件系统作为数据存储服务的载体;

- 可以实现文件系统级别的数据共享服务;

- 可以实现远超远距离的数据存储服务。

为什么NAS和SAN存储逐渐取代了DAS存储?

随着信息化的不断发展,应用系统逐渐由单机式的业务模式发展为CS/BS的前后台组合模式,业务系统之间的耦合性越来越强;数据的重要性逐渐凸显,对企业存储的安全性和稳定性有更高要求;数据量的增长不再是定格在某个业务系统的模式,更多的是系统群的数据增长模式,而这种变化对企业存储的灵活性、扩展性以及容量本身都提出了更高的要求。在这些变化的驱动下,NAS和SAN存储必然取代DAS。

- SAN存储与服务器实现了物理连接的解耦;

- SAN存储可以在应用服务器之间实现存储设备的共享;

- SAN存储与服务器之间的链路实现了高度冗余,在性能和高可用都得到质变;

- NAS存储可以支持更灵活的以太网协议;

- NAS存储可以实现文件系统级别的数据共享;

- NAS存储可以实现超远距离的数据存储服务。

为什么SAN存储虽然是企业存储主流,但也始终无法取代NAS?

或许我们可以举出很多很多二者之间的区别,从连接协议、数据载体、灵活度等等各个方面都会有一些差异导致不同场景下的优略。但是我认为最根本原因还是在于性能问题。NAS存储的性能瓶颈在于其传输协议和数据载体类型。20世纪前后,以太网的发展多数停留在千兆级别,与同时代SAN网络的4GB、8GB FC相比,速度相差太悬殊了。文件系统虽然可以直接存放文件,但是其读写的控制机制相比较Block模式来讲要复杂很多,性能开销大打折扣。也许有人会说因为SAN存储大部分应用于数据库类的应用,而数据库类的应用不适合文件系统。表面上这句话没错,但是谁说数据库的容器(DB2)或者数据文件(Oracle)就不能是文件系统上的文件呢,而非得Block存储卷呢?其根本原因还是在于底层的读写性能。

那么反过来,为什么NAS还能一直存在并于SAN存储并存呢?

这个还是取决于它支持的协议和文件的载体,有一些数据存储场景更适合于以太网协议,并且更适合文件系统作为载体。SAN网络要想传输到相对远距离的区域,比如不同楼宇、不同园区、不同地区,从成本上、技术上、灵活性上来看都会力不从心。Block存储要想实现数据的共享读写,不是不可以,但是必须得依赖于应用的共享控制机制,比如HA软件和LVM,而NAS存储天生支持NFS和CIFS共享协议。

SAN&NAS存储架构在自己的时代又经历了哪些进化?

在属于自己的时代里,SAN和NAS存储架构围绕着扩展性、高可用、性能以及TCO等因素各自伴随着新的软硬件技术诞生发展而衍生出新的发展趋势。

1). 存储控制器的扩展性发展趋势。

最初的SAN存储基本属于双控制架构,两个控制器的工作模式由最初的AS模式发展为AA模式,为整个存储系统提供数据的读写控制服务,后续逐渐发展为网状架构多控的负载均衡集群模式。

2010年HP公司完成对3PAR公司的收购,标志着HP存储系统从原来的双控四控EVA存储架构转化为网状架构的8控、16控高端SAN存储架构。2011年,EMC公司将其Symmetrix VMAX产品定位为主推产品,意味着其SAN存储产品由原来的双控VNX产品系列转化为网状多控集群架构。

这个变化导致了SAN存储在吞吐量、性能、高可用、容量等方面都得到了质的飞跃。

2). 虚拟存储卷的池化技术越来越精湛,映射单元粒度变小、数据分散度提高。

最初基于双控模式的SAN存储的虚拟存储卷一般是基于物理磁盘组基础之上做一次分配和映射形成虚拟卷,后续的SAN存储虚拟卷逐渐发展为多层映射并且最小的物理存储单元粒度越来越小。

以EMC的VMAX为例,其存储卷Virtual Volume到Physical Disk之间除了有DiskGroup的概念,还有Physical Device、Virtual Device、Storage Pool、Thin Pool等多个对象,正是这些对象的多层映射使得提供存储服务的虚拟存储卷所对应的实际物理存储空间映射到了成百上千块物理磁盘的小粒度存储单元空间上。

这种技术的改变一方面逐渐消除热点数据集中在局部物理存储空间的可能性,提高了数据读写的整体性能。另外一方面,数据在物理存储磁盘上的分散程度提高,可能面临的物理磁盘故障对数据安全性影响变小,提高故障数据的恢复速度以及降低数据恢复过程对存储系统的性能影响。

3). 存储管理软件功能越来越完善,越来越强大。

随着高端SAN存储的不断发展,尤其是2015年之后的发展阶段,高端SAN存储上逐渐增加了数据空间利用率管理、数据保护管理、数据性能管理等方面的各种软件功能。

数据消重功能:其功能就是在存储端将上层应用存储的重复数据保留一份,从而提高物理空间的利用率。其本质上是以BLOCK为单位进行数据对比,仅在物理存储空间保存一份,而在虚拟存储卷到物理空间的映射上增加指针的软件技术。

数据压缩功能:其功能就是在存储端将读写访问频度较低的数据,基于压缩算法进行数据压缩,提高物理空间的利用率。具体压缩算法有很多,压缩类型也包括有损和无损两种。但是无论是什么算法什么类型,其对CPU的消耗是必然的,如果刚刚压缩的数据又被访问到的概率越高,解压的代价就越高。

克隆技术和快照技术:存储卷的克隆技术是指在存储设备上,基于存储卷的Block存储单元而进行完全复制形成的完全相同的存储卷,用来做数据备份恢复。快照技术是指基于某个存储卷的Block存储单元而进行指针映射而形成一个虚拟的存储卷,同样用来进行数据备份恢复。需要注意的是克隆出来的卷虽然数据完全一样,但是存储卷的元数据信息是不一样的,采用存储卷直接替换方式进行系统恢复的时候需要考虑应用对存储卷元数据的识别。快照技术是一种修改即拷贝的机制,使用时需要注意数据修改对存储空间使用的影响。

瘦存储卷技术:瘦存储卷技术也就是存储设备是否支持使用Thin模式。分配卷时并不分配真实容量的物理空间,而是在存储卷需要存储数据的时候才会逐渐分配物理空间。同样也是基于企业TCO的考虑。将应用在一段时间内可能需要的存储规模划定好,但是真实的物理存储空间是逐年扩容投入并且是按需投入。但是需要考虑使用溢出的风险。

数据分层技术:通俗理解数据分层技术就是把正确性能要求的数据放在正确性能的存储载体上。存储磁盘有快有慢,成本与性能成正比,为了平衡TCO与性能要求的不可预见性,通过软件算法自动将不同性能要求的数据放在不同读写速度的物理磁盘上。

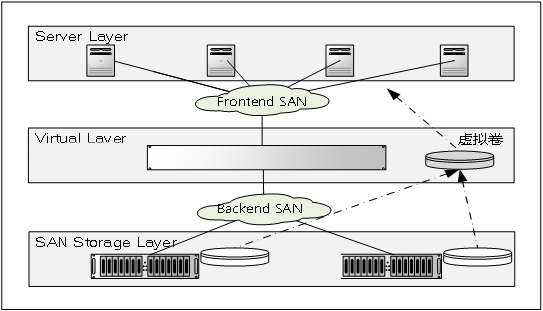

4). 随着存储虚拟化技术的发展,其逐渐成为企业容灾框架的关键技术。

SNIA(Storage Networking Industry Association)存储网络工业协会对存储虚拟化是这样定义的:通过将一个或多个目标(Target)服务或功能与其它附加的功能集成,统一提供有用的全面功能服务。通俗讲,虚拟存储技术将底层存储设备进行抽象化统一管理,向服务器层屏蔽存储设备硬件的特殊性,而只保留其统一的逻辑特性,从而实现了存储系统集中、统一而又方便的管理。对比一个计算机系统来说,整个存储系统中的虚拟存储部分就像计算机系统中的操作系统,对下层管理着各种特殊而具体的设备,而对上层则提供相对统一的运行环境和资源使用方式。

SAN Storage Virtual Gateway Layer

- 通过SAN网络的ZONE隔离策略将SAN网络在逻辑上隔离为前后端网络,前端包括服务器和存储虚拟化网关设备,后端包括存储虚拟化网关设备和SAN存储设备;

- 存储虚拟化网关层代替SAN存储向服务器提供存储卷服务;

- 存储虚拟化层提供给服务器的存储卷是经过了整合或者镜像之后的虚拟化卷。

从SAN存储的虚拟化技术发展历史来看,其实最初的虚拟化技术主要的是实现存储卷的集成功能,更多的是企业存储立旧的目的。例如IBM的V系列存储最初的存储卷虚拟化功能就是要实现对IBM系列老旧存储的集成。V系列存储的虚拟存储卷可以由多个物理存储设备上的物理卷组成。但是随着IBM SVC产品以及EMC VPlex等产品的出现,存储虚拟化技术主要用来做1:1镜像存储卷实现数据在不同区域的高可用保护或者是容灾保护。

另外一方面,存储控制器的虚拟化发展模式更加促进了容灾技术的逐步完善。近些年来随着计算虚拟化的不断发展,操作系统虚拟化及容器的概念不仅仅改变了服务器的使用习惯,而且部分引入到了存储操作系统的管理当中,存储控制器由物理节点为虚拟节点,可以对控制器的网络、存储卷、缓存、CPU等资源动态重组并实现在物理硬件上的平滑迁移,最终提高容灾系统的RPO。例如Netapp的FAS产品系列的Data Ontap。

5). 存储架构逐渐走向整合模式。

存储架构逐渐走向统一整合的模式主要体现在3个方面:

NAS存储功能和SAN存储功能逐渐走向整合。同时兼备NAS功能和SAN存储功能的产品逐渐增多,Netapp由最开始的NAS专注者转变为统一存储提供者,从FAS8000系列开始,其产品兼备NAS、SAN以及存储虚拟化容灾功能。EMC VMAX 10K还仅仅是一个独立的SAN存储,从VMAX 20K开始已经转变为兼具NAS功能的统一化存储产品。

高性能小容量磁盘介质与低性能大容量磁盘介质走向整合。SAN存储发展到2015年前后,细数各家存储设备厂商的高端存储设备,基本上分层管理技术(FAST)已经成为其必备功能。分层技术已经发展到可以针对分层的时间窗口以及分层的性能指标等多个维度进行自定义。企业也越来越多得开始使用这种技术来平衡企业存储投入TCO。

存储运维管理走向统一化。在存储虚拟化技术的基础之上,越来越多高端存储产品具备对不同类型甚至不同品牌的存储产品进行管理上的整合。以EMC的VPlex为例,其不仅仅可以兼容EMC自己的存储产品系列,而且可以兼容很多其他品牌的存储产品,然后在其之上形成一层虚拟化存储抽象层,从而实现存储管理工作的统一化和便捷化。

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞14本文隶属于专栏

作者其他文章

评论 10 · 赞 17

评论 2 · 赞 14

评论 5 · 赞 4

评论 0 · 赞 10

评论 1 · 赞 10

添加新评论0 条评论