仅仅换个CPU,Ceph集群性能就变2倍,亲测有效,but why ?

1 测试总体

1.1 待测功能

本次测试使用Ceph 块存储功能,将SSD作为Ceph OSD,在其中创建存储卷,采用RBD映射的方式,将存储卷映射到压力机上。

1.2 测试目的

本次性能测试的目的是评估Ceph Jewel版本(10.2.10) 在 K1 Power 服务器上的性能。

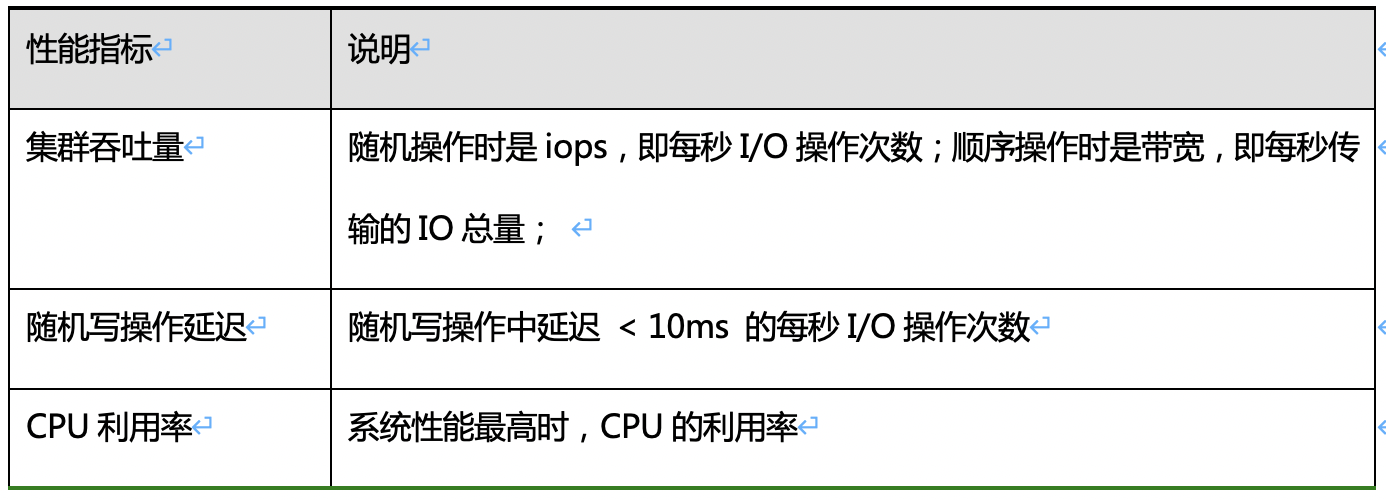

1.3 性能评价指标

2.2 服务器配置

2.2.1 Ceph集群配置

ü 硬件配置

3台 K1 Power FP5280G2 服务器,每台 23 个OSD,每个OSD占用一块SSD

2.2.2 压力机配置

压力机配置:

ü 硬件配置

2.3 测试方法

将SSD接入Ceph,并建立单独的pool。在该pool上创建卷,然后挂载到压力机上,跑FIO测试。

Ø SSD总共69块,每块一个OSD,总共3台Ceph存储服务器,每台23个OSD

Ø 服务器内存256GB,设置缓存为每个OSD 2GB

Ø 总共创建50个卷,每卷大小40GB,测试前先预写一遍

Ø FIO使用libaio引擎,direct模式,单线程

深度iodepth=8

随机写,混合(比例1:1)(4KB,16KB)

顺序写,混合(比例1:1)(64KB,512KB)

Ø 每场测试10分钟。

3 测试结果

3.1 随机写场景

3.1.1 randwrite 4k

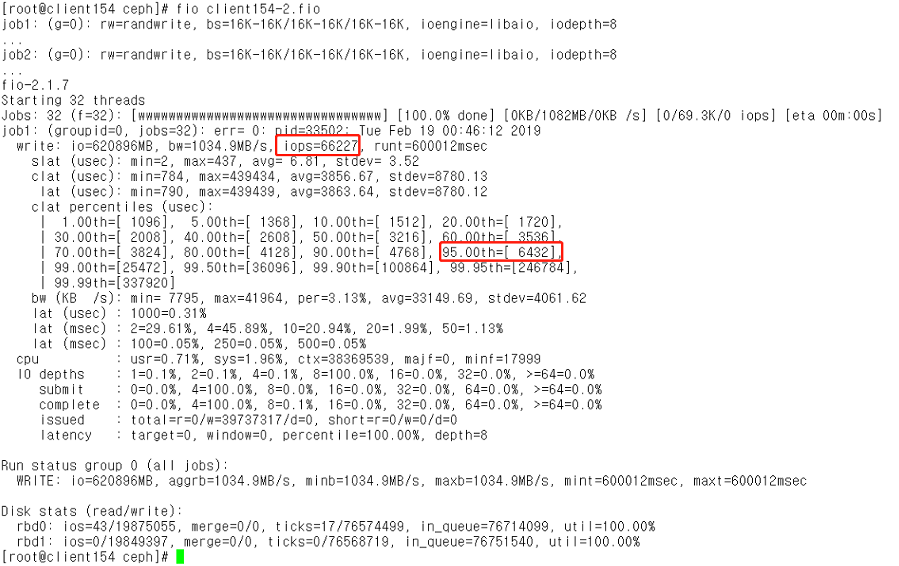

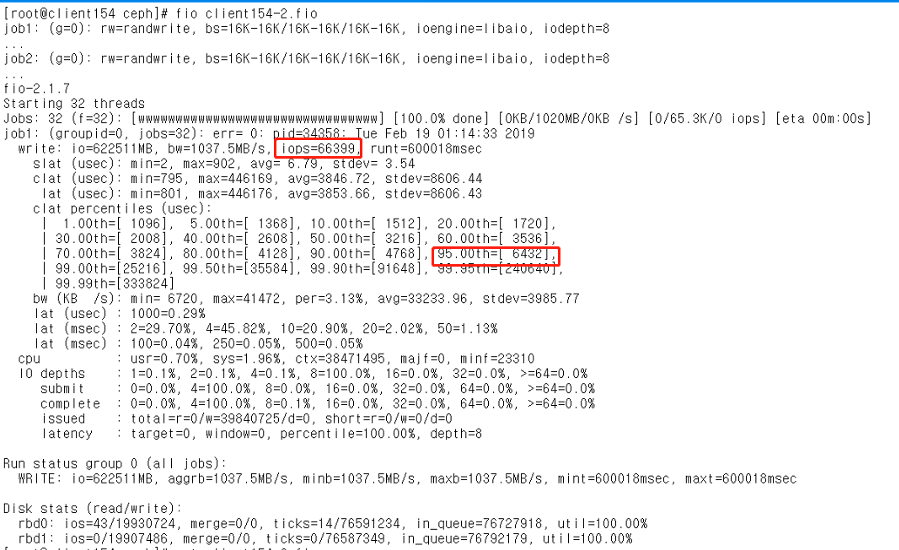

3.1.2 randwrite 16k

3.2 随机读写场景

读写比例为1:1

3.2.1 randrw 4k

3.2.2 randrw 16k

3.3 顺序写场景与顺序读写场景

4 测试结果分析

4.1 测试结果

4.2 关键指标分析

Ø 集群吞吐量指标

这里没有给出同期进行的x86集群的性能测试结果,2个集群除了CPU不一样,其他如内存,网络,Ceph配置,测试工具,测试参数等都一样。x86使用的是 2 sockets Xeon gold 6130,随机写性能只有 K1 Power 的一半,并且CPU基本跑满。这表明在相当的硬件配置情况下,K1 POWER运行Ceph相比x86具有很大的性能优势。

Ø CPU利用率指标

测试结果表明在SSD盘几乎跑满的情况下,K1 Power 的 CPU利用率只有一半。这意味着在保证客户体验的前提下,K1 POWER能响应更多的用户请求。 同时在该场景下K1 POWER的CPU利用率平均为50%左右,而x86已用满,意味着如果换成性能更好的NVMe磁盘,K1 POWER的性能仍然会有非常大的提升空间,而x86不会有提升。

4.3 测试场景分析

Ø randwrite/randrw 场景是实际应用中最典型的两个场景,该场景对Ceph服务器的CPU/Network/Disk都会产生比较大的压力,最能考察Ceph服务器的真实性能。

Ø seqwrite/seqrw 场景中会对客户端机器和网络产生很大的压力,在客户端机器和网络不是瓶颈的前提下,能压到Ceph服务器磁盘的瓶颈。建议配置绑定两个万兆口,并且提供一个千兆口作为 public network。 万兆bonding作为cluster network或者使用25Gb或者40Gb、100Gb的网卡。

Ø randread/seqread 场景因为缓存的作用,性能受限于网络带宽,Ceph集群端基本没有压力,不建议用做评估服务器性能。

5 结论

Ceph 作为广泛使用的分布式存储软件,其集群性能的提升是所有架构师和运维人员关注的重点,而K1 Power能够在其他条件不变的情况下,相比较主流x86取得2倍的性能,凭借的是如下几点核心优势:

SMT----并发多线程技术,使得K1 Power在2路服务器上提供高达176个线程,即在Linux下,可以看到有176个逻辑核,很显然在分布式存储这种高并发场景具有先天优势。

L3 Cache----超大的L3缓存,K1 Power 每个socket可以提供100MB L3 缓存,是x86的3倍以上,可以缓存更多的热点数据。

核间互联带宽----K1 Power的每个socket核间互联带宽高达7TB,可以快速在核间传输数据。

PCIe Gen4 总线----K1 Power使用PCIe Gen4 总线标准

尤其当全SSD这种使用场景时,可以看到2路K1 Power 服务器可以把 23块SSD全部跑满,而且CPU利用率只有一半。相同配置下,x86 CPU已经跑满,而SSD性能还有发挥空间。

如果您在考虑部署全SSD的Ceph集群,相信 K1 Power 是更优的选择,关于价格,价格公道,面谈有惊喜哦 !

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞2作者其他文章

评论 0 · 赞 0

评论 0 · 赞 0

评论 0 · 赞 0

评论 0 · 赞 0

评论 1 · 赞 1

添加新评论0 条评论