EMC VMAX100K 存储系统维护手册

EMC VMAX100K 存储系统维护手册

第一章 前言

1.1 客户背景

随着 XX 公司信息化程度的提高, XX 公司现有业务对信息系统的依赖程度越来越高。按照 XX 公司信息系统建设总体规划,实现大数据集中管理的基础平台。 XX 公司信息系统,数据量增长迅速,实时性要求高,这些都对数据存储系统提出了更高的要求。而目前磁盘阵列已运行多年,容量和性能已逐渐难以满足应用的需要,急需进行升级扩容。

1.2 项目概况

1.2.1 项目目标

本次项目的建设目标是: 根据 XX 公司 XX 项目的总体规划 ,在 XX 公司数据中心建设高性能和大容量数据集中存储系统,满足 XX 系统的运行需要。

本期项目主要建设内容包括:

1、 完成新的 SAN 存储网络的搭建;

2、 使用本次采购的高端存储设备作为本项目的集中存储设备,满足 XX 平台的数据库和虚拟化平台的空间需求。

1.2.2 项目硬件配置

| Hardware | |

| Item | Count |

| S/N: | |

| VMAX 100K Engine (1024GB) | |

| VMAX 100K Vault Flash SLIC (1600GB) | |

| VMAX 100K 8MM 8G FIBRE | |

| VMAX 100K Drive: 960GB FLASH R1 | |

| VMAX 100K Drive: 600GB10K SAS R1 | |

| VMAX 100K Drive: 600GB10K SAS R5(3+1) | |

| VMAX 100K Drive: 960GB FLASH Spare | |

| VMAX 100K Drive: 600GB10K SAS Spare |

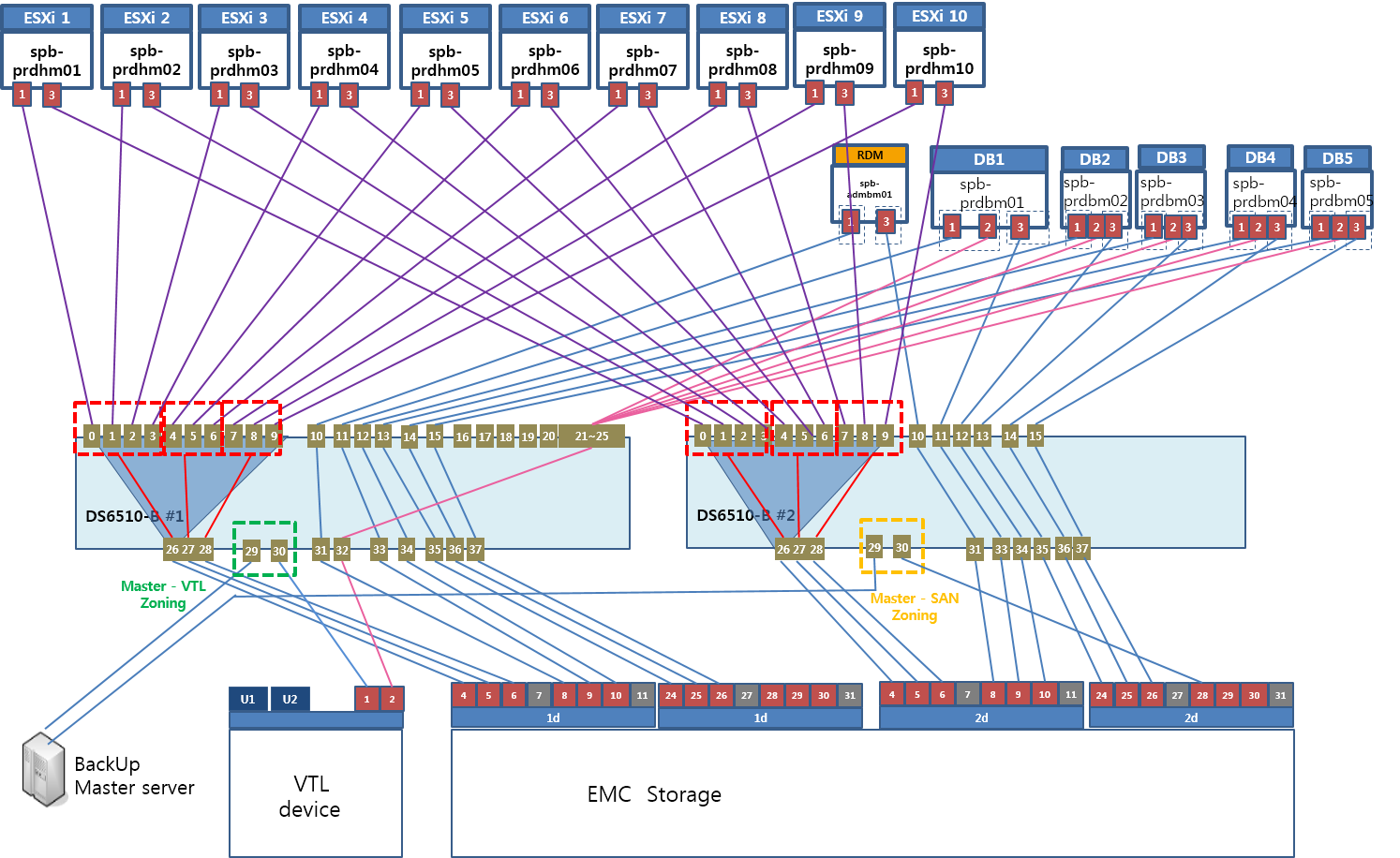

1.2.3 目标架构

目前项目已经完成预期实施,存储访问架构如下:

本项目共 1x 台 ESXi Server , x 台 DB server , x 台 DS6510 交换机构建存储 SAN 网络, EMC VMAX100K 高端存储作为本项目的核心存储。

1.1 项目实施计划

1.1.1 工作概述

本次的存储全部采用新的硬件环境。存储实施工作如下:

- 配置基于 DS651 的 SAN 环境

- 配置 VMAX100K 存储为 Multi-SRP ,创建 2 个 SRP ,分别为 Raid1_SRP 和 Raid5_SRP

配置服务器访问 VMAX100K 存储

1.

1.1.1 实施计划

所有的设备都在同一数据中心,实施计划如下:

第一步:首先,与用户讨论需求,并且准备实施方案

第二步:搭建硬件平台,包括 2 台 DS651 、 1 台 VMAX100K 硬件安装、加电、初始化配置。

第三步:所有服务器、存储设备光纤线连接

第四步:安装 Unisphere For VMAX 管理服务器

第五步: SAN 交换机 zone 配置

第六步: VMAX100K 存储 Virtual Provisioning 配置

第七步:主机识别磁盘。

目前,已经按预期计划完成了项目实施,如下内容介绍本次实施内容和今后的技术维护方法。

第二章 VMAX100K

2.1 VMAX100K 安装配置

2.1.1 VMAX100K 硬件初始化

VMAX100K 出厂时,会根据项目前期确定的 VMAX100K 的配置,对阵列进行初始化配置。本项目应客户要求不采用出厂配置,按照 Raid 方式划分为 2 个 SRP ,即采用 Multi SRP 的解决方案。此配置已通过 EMC CCA 审批流程。

VMAX100K 运到客户机房后, EMC 硬件工程师对 VMAX100K 进行如下检查和操作。

l VMAX100K 内部连线进行检查

l 加电后对 VMAX100K 做健康检查

l 把微码升级到最终目标版本

l 加载审批后的 Bin File

l 加载客户购买的 License 。

2.1.2 VMAX100K 配置

2.1.2.1 新申请后的 Bin 配置

VMAX100K 安装加电后,就可以直接使用。 XX 公司 2 台 VMAX100K 的配置信息如下:

所有的空间按照不同的 Raid 保护方式放在不同的两个存储资源池下面。

存储资源池信息:

| SRP名称 | 磁盘类型 | 可用容量 | Disk Group | 保留空间比例 |

| Raid1_SRP | 600GB 10K | 22.5 TB | 1 | 10% |

| 960GB Flash | 3.4 TB | 3 | ||

| Raid5_SRP | 15.7 TB | 2 | 10% |

2.1.2.2 创建 Storage Group 和 Thin Device

给服务器分配空间,在 VMAX100K 上就是做创建 Thin Device 和 LUN Masking (分配 Thin Device 给服务器)。如下内容说明如何创建 Thin Device 和 LUN Masking 。创建 Thin Device 采用如下方法。

创建 Thin Device 可以采用命令行方式,也可以采用图形界面操作。

一套主机认的 Lun 放在一个 Storage Group 中。

2.1.2.2.1 创建 Storage Group

本项目中,所有的 Storage Group 采用 Cacade Storage Group 的方式,在同一台主机上将 Raid1 的 Lun 和 Raid5 的 Lun 放在 2 个不同的 Storage Group 中,并作为 Child Storage Group 。将这 2 个 Child Storage Group 放在 1 个 Parent Storage Group 中。

以下为命令示例:

Ø 创建 Child Storage Group ( Raid1 )

# symsg -sid 302 create prdbm_my1_R1_loc_sg -slo Optimized -srp Raid1_SRP

Ø 创建 Child Storage Group ( Raid5 )

# symsg -sid 302 create prdbm_my1_R5_loc_sg -srp Raid5_SRP

Ø 创建 Parent Storage Group

# symsg -sid 302 create prdhm01_sg -nosrp -noslo

Ø 将 Child Storage Group 加入 Parent Storage Group

#symsg -sid 302 -sg prdbm_my1_sg add sg prdbm_my1_R1_loc_sg,prdbm_my1_R5_loc_sg

2.1.2.2.2 创建 Thin Device

划分 Thin Device 的基本存储单元是 Cylinder (柱面),一个 CYL=1920KB ,也就是说给服务器分配的 LUN 大小为 1920KB 的倍数。在具体创建 Thin Device 时,可以采用 GB 、 MB 、 CYL(Cylinder) 标量,如果使用 GB 和 MB 创建 Thin Device 也是按照 1 个 Cylinder 大小的倍数分配,例如创建 1GB 的 Thin Device ,实际空间是 547CYL ,也即 1.00158691GB 。创建命令如下,参数 Preview 是模拟创建,当 Preview 执行成功没有报错后,再执行 Commit 正式提交配置。

以下为命令示例:

Ø 创建 Raid1 的 600GB 的 Lun ,并加入 Raid1 的 Storage Group 中

# symconfigure -sid 302 -cmd " create dev count=1, size=600 GB, emulation=FBA, config=TDEV, sg=prdbm_my1_R1_loc_sg;" preview –nop

# symconfigure -sid 302 -cmd " create dev count=1, size=600 GB,emulation=FBA, config=TDEV, sg=prdbm_my1_R1_loc_sg;" commit –nop

Ø 创建 Raid5 的 300GB 的 Lun ,并加入 Raid5 的 Storage Group 中

# symconfigure -sid 302 -cmd "create dev count=1, size=300 GB, emulation=FBA, config=TDEV, sg=prdbm_my1_R5_loc_sg;" preview –nop

# symconfigure -sid 302 -cmd "create dev count=1, size=300 GB, emulation=FBA, config=TDEV, sg=prdbm_my1_R5_loc_sg;" commit –nop

命令解释:

在阵列序列号 302 的阵列上创建 1 个 Raid1 的 600GB 大小的 Lun 和 1 个 Raid5 的 300GB 的 Lun

参数解释:

“ -sid ” 是 VMAX3 的序列号的最后 3 位,本项目购买的存储序列号后 3 位为 302

“ -cmd ” 是执行创建 Thin Device 的详细命令

“ count= ” 创建 Thin Device 的个数

“ size= ” 创建单个 Thin Device 的大小

“ sg= ”添加的 Storage Group

2.1.2.3 LUN Masking

LUN Masking 即把创建好的 Thin Device 分配给服务器,具体方法如下

2.1.2.3.1 LUN Masking 步骤

有 2 种方法执行 LUN Masking 。

方法 1 :通过如下 4 步完成磁盘分配

¬ 创建 initiator group

¬ 创建 port group

¬ 创建 view

方法 2 :按如下步骤完成磁盘分配

¬ 一步创建 View 、 Initiator Group 、 Port Group 、 Storage Group

¬ 增加其余光纤卡到 Initiator Group

2.1.2.3.2 创建 initiator group

创建 initiator group ,就是把一个访问存储的应用的服务器的光纤卡加入一个组,这个组称作 initiator group 。一般访问相同存储空间的一个应用建立一个 initiator group 。创建方法如下:

Ø 创建 Initiator Group

# symaccess -sid 302 -name prdbm_my1_ig -type init create

Ø 向一个 Initiator group 增加光纤卡的 wwn ,命令如下:

# symaccess -sid 302 -name prdbm_my1_ig -type init add -wwn 50014380062dd700

# symaccess -sid 302 -name prdbm_my1_ig -type init add -wwn 5001438012077980

参数变量说明:

“ 302 ”是阵列的序列号

“ prdbm_my1_ig “是 initiator group 的名称

“ 50014380062dd700 ”是光纤卡的 WWPN

2.1.2.3.3 创建 port group

创建 port group ,就是把一个应用要访问的存储端口加入一个组,这个组称作 port group 。一般访问相同存储空间的一个应用建立一个 port group 。创建方法如下:

Ø 创建 port group :

# symaccess -sid 302 -name prdbm_my1_pg -type port create

Ø 向 port group 增加阵列端口:

# symaccess -sid 302 -name prdbm_my1_pg -type port add -dirport 1D:09

# symaccess -sid 302 -name prdbm_my1_pg -type port add -dirport 2D:09

参数变量说明:

“ 66 ”是阵列的序列号

“ vplex1 “是 port group 的名称

“ 1d:4 ”是阵列的前端口名称

2.1.2.3.4 创建 view

创建 view 就是把具有关系的一个 initiator group 、一个 port group 、一个 storage group 加入 1 个 view 。一般一个应用创建一个 initiator group 、一个 port group 、一个 storage group ,并且创建 1 个 view ,把这 3 个 group 加入。创建方法如下

2.1.2.3.4.1 创建 view

创建 view 的命令如下:

symaccess -sid 66 create view -name vplex1 –ig vplex1 –pg vplex1 –sg vplex1

参数变量说明:

“ 66 ”是阵列的序列号

“ vplex1 “是 view 的名称 ( 其余的分别是 initiator group 、 port group 、 storage group 的名称 )

2.1.2.4 Unisphere for VMAX 安装

2.1.2.4.1 安装要求

• 必须安装 Solutions Enabler V7.5.1 或更高版本,并且必须运行 storstpd 守护程序(用于 SPA 数据收集)

• 阵列微码要求:

ü Symmetrix VMAX 10K/20K/VMAX 系列要求 Enginuity 5875 以上

ü Symmetrix VMAX 40K 系列要求 Enginuity 5876 以上

ü Symmetrix DMX 系列要求 Enginuity 5671 以上

• 安装 Unisphere for VMAX 服务器要求:

如果计划使用 QoS 和 Replication 功能,必须把操作系统的语言环境设置为“英语”

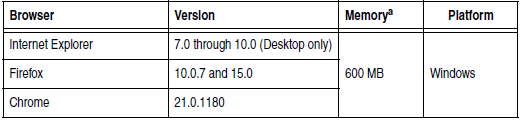

• 客户端要求如下:

需要安装 Flash Player 11.2 以上的版本。

• Linux 操作环境必须存在 MySQL 用户和 MySQL 组:当在 Linux 上执行新的 Unisphere for VMAX 安装时,在开始安装 Unisphere for VMAX 之前必须存在 MySQL 用户和 MySQL 组。命令参考如下

groupadd mysql

useradd -g mysql mysql

• 支持与 EMC ControlCenter 结合

• 支持 VMware 和 Hyper-V 环境安装 Unisphere for VMAX 。对 VMware 和 Hyper-V 的版本支持如下:

ü VMware ESX/ESXi Server versions 4.0, 4.1, 5.0, and 5.1

ü Windows Server 2008 R2 (Standard and Enterprise)

• 许可:阵列的微码在 5876 以上需要安装 SMC E-License

注: 当升级 Solutions Enabler 时,必须在升级之前停止 Unisphere for VMAX 服务,然后在升级完成后启动该服务。

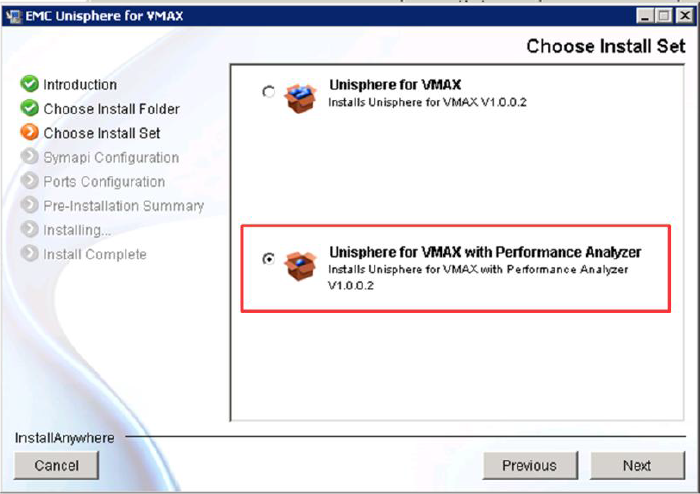

1.1.1.1.1 安装方法

Windows 平台下的安装方法如下:

- 双击安装文件进行安装。

- 当打开 Unisphere for VMAX 安装程序时,将显示一个对话框窗口,可以在其中选择安装 Unisphere for VMAX 或者 Unisphere for VMAX with Performance Analyzer 。选择 Unisphere for VMAX ,将安装除了性能以外的管理功能;选择 Unisphere for VMAX with Performance Analyzer ,将安装 Unisphere for VMAX 的所有功能。如此处所示。

- 按“ Next ”按钮之后,将出现“ SYMAPI Connection Type ”窗口,可以选择 Local 或者 Remote 。 Local 是通过本地 Solution Enabler 管理 Symmetrix ; 选择 Remote 是通过其它服务上的 Solution Enabler 管理 Symmetrix 。

- 按“ Next ”按钮之后,将出现“ Ports Configuration ”窗口,显示 Unisphere 的默认端口。默认情况下,端口是 8443 。

- 其余选择默认选项进行安装。

1.1.1.1.1 启动服务

Windows 环境会自动启动 Unisphere for VMAX 服务。也可以在 Windows 的服务管理界面启停服务 (SMAS) 。也可以使用如下命令启停服务:

net start "EMC Symmetrix Management Application Server"

net stop "EMC Symmetrix Management Application Server"

net start "EMC_smasdb"

net stop "EMC_smasdb"

1.1.1.1.2 启动管理界面

通过客户端浏览器访问 Unisphere for VMAX 的安装服务器 IP 和 TCP 端口 8443

打开登录界面后,输入用户与口令。缺省为 smc/smc

进入主界面后,可以选择阵列进行管理。

1.2 VMAX 维护

1.1.1 保修流程

1.1.1.1 存储信息

| 阵列名称 | 序列号 | 微码版本 |

| VMAX100K |

1.1.1.2 售后支持

设备在使用中有任何问题,请联系 EMC24小时支持热线:

固话拨打: 800-819-0009

手机拨打: 400-670-0009

请提供故障设备的序列号,并记录 case号码

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞2作者其他文章

评论 6 · 赞 9

评论 2 · 赞 4

评论 0 · 赞 2

评论 0 · 赞 2

评论 6 · 赞 6

添加新评论0 条评论