金融行业存储技术趋势之全闪存存储架构选择及性能优化在线探讨——内容整理

议题内容集锦

核心议题-为什么说存储阵列和分布式存储全闪存化大势已成,全闪存解决哪些问题,带来哪些优势?

聂奎甲 项目经理 长春长信华天

全闪存带来了磁盘速度飞速的提升,解决了很多因存储瓶颈造成的业务延迟。

wangshuai_go 存储工程师 平安科技

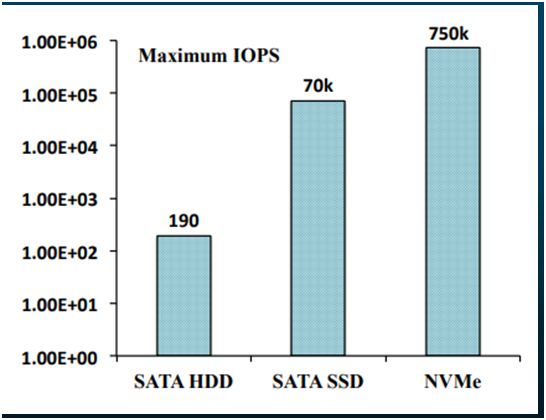

主要SSD介质带来IOPS 性能的大幅提升,带来的读写延迟的大幅下降。这是HDD机械盘存储系统靠堆HDD盘数量所无法解决的。

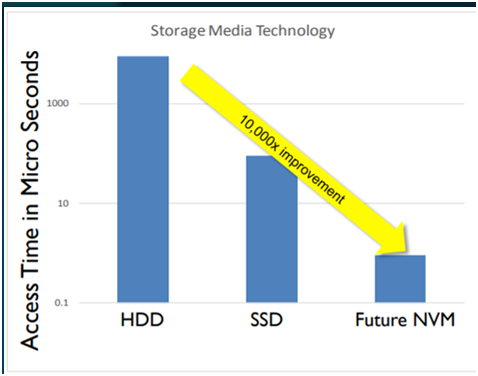

不同存储介质的速度比较

存储介质从HDD到STAT/SAS SSD 再到NVMe SSD 延迟降低了10,000倍!!!

基于2015年的4KB 随机读测试数据显示最大IOPS 方面:SATA HDD是190个IOPS, SATA SSD 是70K个IOPS,而NVMe SSD 的IOPS 超过SATA SSD 10倍达750K个 IOPS。

存储介质从HDD到STAT/SAS SSD 再到NVMe SSD IOPS性能能力提升了3000多倍!!!

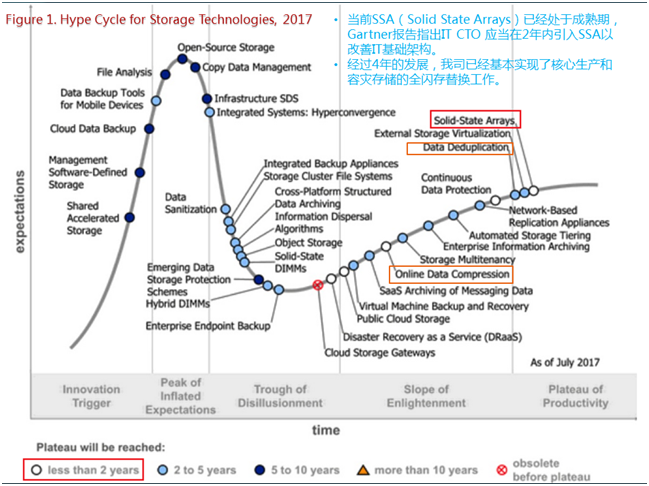

当前SSA(Solid State Arrays)已经处于成熟期, Gartner报告指出IT CTO 应当在2年内引入SSA以改善IT基础架构。

经过4年的发展,我司已经基本实现了核心生产和容灾存储的全闪存替换工作。

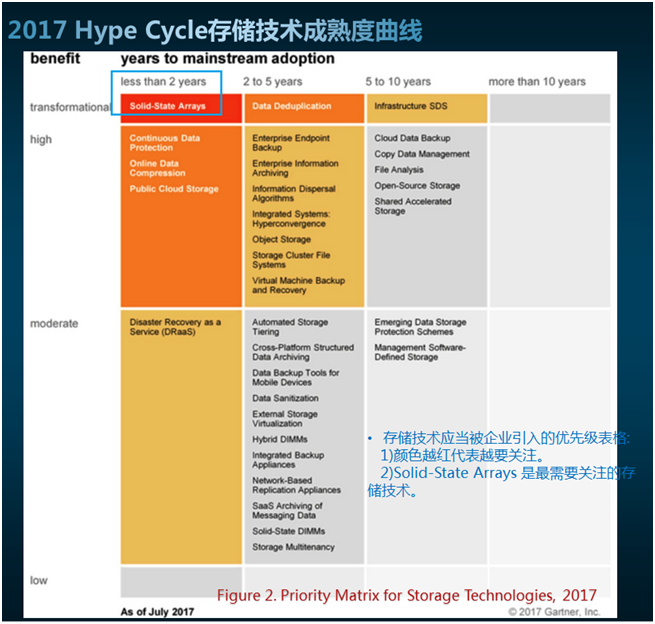

2017 Hype Cycle存储技术成熟度曲线

存储技术应当被企业引入的优先级表格:

1)颜色越红代表越要关注。

2)Solid-State Arrays 是最需要关注的存 储技术。

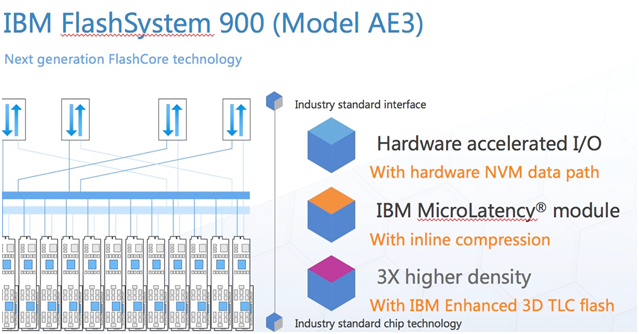

ibmfuqiang 系统架构师 IBM

如果一客户可以在单位成本能获取更高的性能,更低的延迟,更有效的生产力,那何乐而不为呢?何况现在闪存的价格也在慢慢趋于更合理的区间。说明一下,ibm在2017 4季度全面更新全闪存新产品新特性,主要包括三个方面:1,在硬件加速构架设计上已经全面使用NVM技术,2,支持在线压缩技术 3, 支持3D TLC高密度集成,容量上原来产品的三倍。如下图示:

辛旻讲IT 全球领先的IT服务平台

主要是性能

核心议题-当前制约全闪存存储性能发挥的主要瓶颈是什么,如何优化?

聂奎甲 项目经理 长春长信华天

大多数客户都会担心全闪存存储的稳定性,但目前所有的全闪存存储都支持类似metro mirror配置,可以保证数据的双冗余架构,来保障数据的可靠性。同时本身全闪存存储都是多冗余架构,从控制器到硬件卡等等。不尝试永远只是说停留在考虑担忧上,试试最重要。

推荐可以把闪存作生产使用,而且用传统存储做多个备份。

推荐在使用闪存方案时,评估一下每天的IOPS,然后根据闪存芯片使用寿命做一个最好、最坏、最可能的三点计算,提前准备好可替换的设备,另外有raid机制的保护,有热备盘等其它方式的保护,理论上来说是不用担心稳定性的。

系统的正常稳定运行,不仅仅是在硬件方面性能的提升,运维期间对设备运行状态的监控管理和调优都是必备手段。

wangshuai_go 存储工程师 平安科技

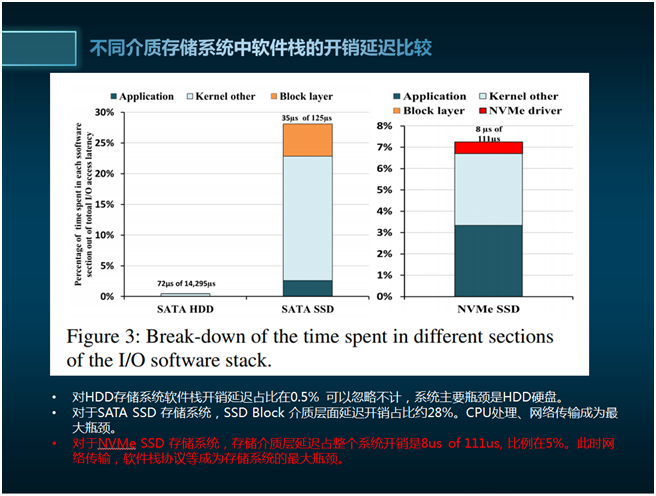

不同存储介质的速度比较

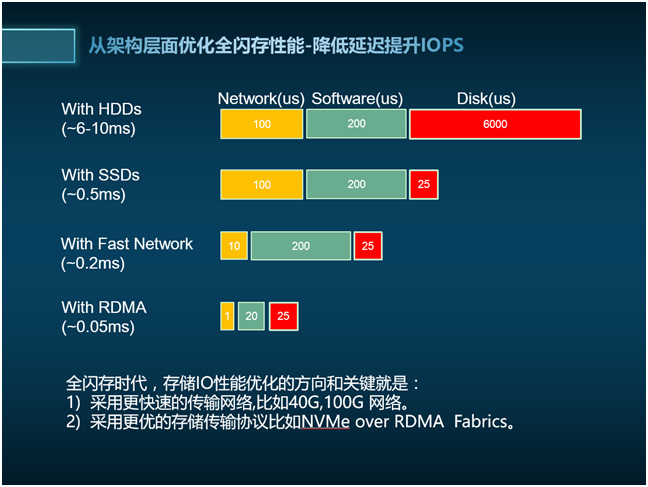

不同介质存储系统中软件栈的开销延迟比较

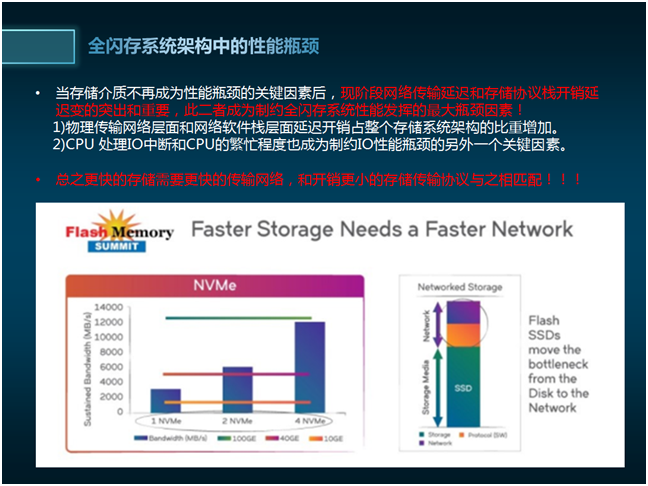

全闪存系统架构中的性能瓶颈

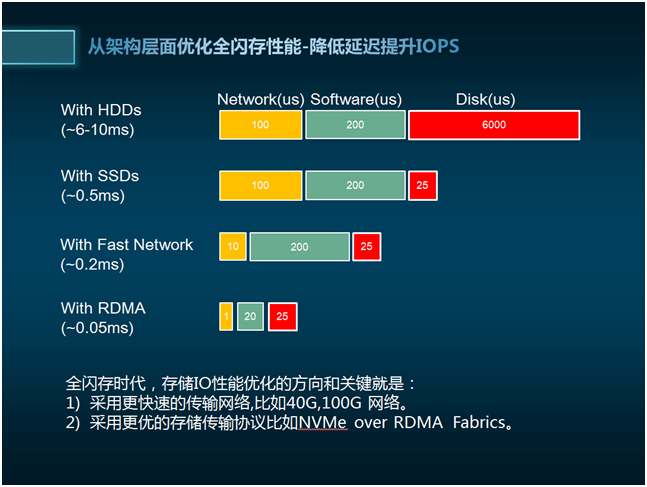

从架构层面优化全闪存性能-降低延迟提升IOPS

核心议题-金融行业上闪存架构的必要性分析?

聂奎甲 项目经理 长春长信华天

大家都想省钱还能办事儿,但有时候,如果你的硬件已经配置到极限,那么也就是说性能也就在这个固有的范围里伸缩,如果这时候性能还是无法满足业务对IO的性能要求,那么你就要给现有的架构做些大动作的调整,如上闪存,从根本的介质上提升性能。总之,好钢用在刀刃上,一定要结合现有业务的瓶颈所在,做好新技术引进的必要性调研。

ibmfuqiang 系统架构师 IBM

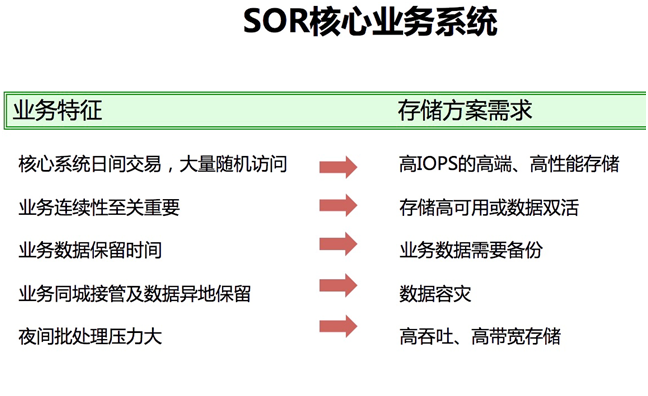

首先,银行主要业务分以下三类,SOR/SOE/SOI都适合使用全闪存存储构架,分析如下:

核心议题-对于金融行业来说,哪些业务系统适合放在全闪存阵列上?

聂奎甲 项目经理 长春长信华天

IO压力大的都适合,目前来看,数据库和vm虚拟化的都表现良好。性能肯定是比较明显的,但是也不能贸然的拿ppt中的8倍 10倍来说。最好有对应的测试数据。比如针对oracle,ibm有个AWR_AutoAnalysisTool工具可以做对应的测试。

wangshuai_go 存储工程师 平安科技

数据库小IO size 随机读写业务非常适合放置全闪存上。

如果是以视频,归档,顺序高吞吐带宽读写为主的应用,建议还是放置在HDD存储系统上就能满足,并且成本要低的多。

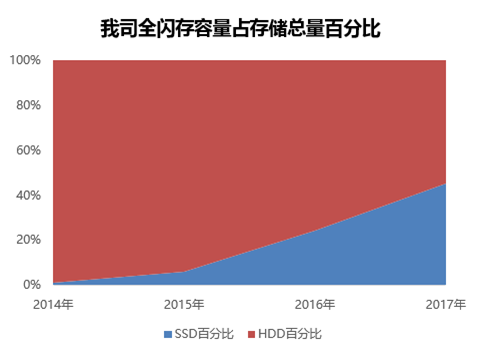

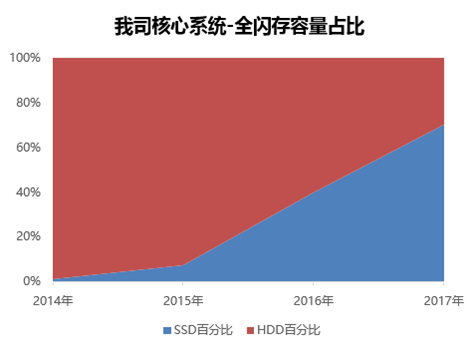

以下分析以下我司闪存使用情况:

作为知名保险的我司有幸成为国内最早一批引入全闪存的公司。从2014年开始经过4年时间我司已经基本完成全部核心生产和容灾系统的全闪存替换工作。

未来100%的核心系统都将实行全闪存化,我司引入了包括AFA(All Flash Array)全闪存阵列,以及软件定义分布式存储的全闪存存储等多个类型。

ibmfuqiang 系统架构师 IBM

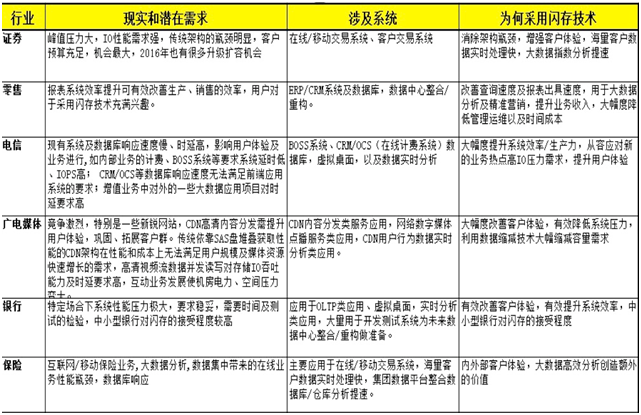

针对金融行业主要包含,银行,保险,证券三大类别,哪些应用业务场景适合在全闪存储上呢?请看下面的分析和概括,希望能有帮助到您:

核心议题-全闪存存储架构实施过程中有哪些难点?贵企业是如何攻克的?

wangshuai_go 存储工程师 平安科技

这里分析一个我司的使用全闪存使用中遇到的一个极其顽固难解决的性能问题案例分享。

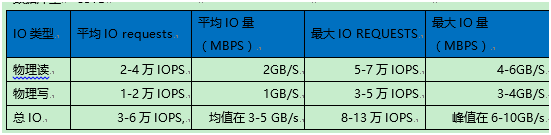

首先说一个我司这变态数据库的IO 模型,绝对够吓人:

数据库量85TB

读写比在2:1左右

顺序读占IO的40%左右,离散度占IO的13%;

读IO size 在150K~350K , 要求读延迟均值<5ms (5万 IOPS,300KB size换算成4KB size 就是越350万IOPS )

写IO size 在 100K~300K ,要求写延迟均值<3ms

请在市场上找出可以满足改数据库的全闪存存储,很多公司的闪存见了都要呵呵绕路走!!!

顽固性能问题描述:

我司两年前用的是SVC +后端FLASH900 架构,用了年后就完全满足不了。今年改成A9000R全闪存后该数据库还是在业务高峰期出现严重IO性能降低的问题。

经过一系列的架构整改终于不再出现性能问题,满足也业务的需求。具体整改方法如下:

单纯的存储端优化-更改存储架构: 随着业务的进一步增加SVC前置压缩 +后端FLASH900 架构也越越频繁的出现性能瓶颈。 首先想到的就更换性能更强大的存储,将该数据迁移到新购置的A9000R全闪存,同时跳出SVC 虚拟化层,从而使存储端有能力提供更高的IOPS和更低的读写延迟。

单纯存储端优化效果: 换了更牛B好几倍的A9000R闪存后。没到2周开始在作业高峰期再次频繁出现IO性能问题,并且在非作业的高峰期只要一发起全备份(在生产主机上直接发起全备份,呵呵这个报表大数据分析库,为了省钱就直接这样备份了。),该数据读写延迟就会上升几十倍甚至百倍,从50ms ~500ms不等。纳尼这那是闪存的性能!!! 于是不停的推动IBM L3分析分析再分析,IBM 分析的结构是说存储是闪存足够快,没有性能瓶颈,瓶颈似乎是在SAN网络延迟方面。

优化SAN网络传输带宽: 之前也一直在做主机端和SAN网络带宽方面的分析。分析下来主机CPU/Memory 不是瓶颈,DISK max util 这个值在性能问题时间段经常保持在70%~95%,这明白说明了存储慢。主机上有6个8GB HBA 口,4个接存储跑业务流量,2个接带库跑备份流量,通过BNA (Brocade Network Aviator )多次观察历史数据发现业务的4个端口从来没有跑满过,FC 链路单向最大带宽使用率也就是在70%,但是发现备份的2个HBA 口在全备份期间总是跑满。

另外一个现象是90%的出现IO漫的情况时,应用慢的时候刚好有全备份在跑,全备份停止几个小时后数据库IO恢复正常。个别时间段业务量大时,在没有备份的情况下IO性能也变慢。

根据以上现象就比较难下手了。但是备份争抢业务IO 导致业务IO变慢这个问题基本可以确定了。备份2 个HBA 口已经跑满,一定要升级优化的,业务的4个HBA 口最大单带宽使用率在70%,预计也快到瓶颈了。

于是和主机组商量后果断切换到新配置主机,新配置主机配置4个16GB HBA口跑业务流量,2个16GB HBA 口跑备份流量。从而完成了SAN网络带宽的升级优化。

优化SAN网络传输带宽效果:效果就是在不跑全备份时再也没有出现过应用IO慢的情况了。 而且还有一个现象就是在旧的主机上4个8GB业务HBA 口时,存储到该数据库的最大FC 带宽也就跑到3.5GB 的样子。但是新主机换成4个16GB 的业务HBA口后,最大存储FC带宽竟然一下飙到8GB,均值在3.5GB 相当于老主机上的峰值带宽。这验证了IBM L3的分析,性能瓶颈在SAN网络传输和延迟方面。

HBA 口都升级到16GB后,备份流量带宽也没有跑满了,但是在发起全备份时间段还是偶尔导致应用IO性能满的情况出现。

优化备份架构: 全备份架构整改正“基于存储快照的异机解耦合server free备份”架构。 就是在A9000R存储做快照(数据库端需要begin backup操作),将快照卷挂到另外一台单独的主机上做数据库做全备份。这样就避免了直接在生产主机做全备份,避免了备份IO和业务IO争抢导致业务IO变慢的问题。

优化备份架构后效果: 该数据库在业务高峰时段同时做全备份时也未再报出IO性能问题。

总结:在全闪存时段,根据我司的经验多数性能问题都不是存储本身性能到了瓶颈所致,多数性能瓶颈都是在网络传输层面和架构层面: 比如应该用更快的16GB 网络替换旧一代的8GB 网络,比如要多关注HBA 口,存储FC 端口的queue depth 是否full 跑满,SAN SFP,光纤是否老化等问题。

全闪存系统架构中的性能瓶颈

从架构层面优化全闪存性能-降低延迟提升IOPS

核心议题-当前主流的全闪存阵列品牌型号有那些?软件定义Server SAN全闪存品牌有那些?技术产品选型上应该如何考虑?

聂奎甲 项目经理 长春长信华天

我知道的有IBM F900,V9000, A9000,A9000R等

ibmfuqiang 系统架构师 IBM

补充一下,IBM全闪存存储产品线,如下:

IBM F900,V9000, A9000/A9000R,DS8880系列,以及V7000F/V5030F。

wangshuai_go 存储工程师 平安科技

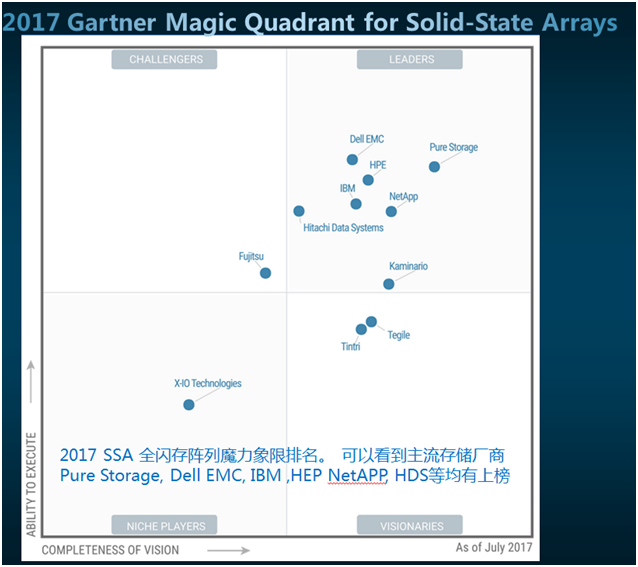

2017 SSA 全闪存阵列魔力象限排名。 可以看到主流存储厂商Pure Storage, Dell EMC, IBM ,HEP NetAPP, HDS等均有上榜

当前主流存储厂商均有推出全闪存的产品线:

Pure Storage

当前最牛的全闪存startup 公司,IDC MarketSPure Storage的FlashArray列为高位。

IBM FlashSystem系列

IBM F900,V9000, A9000/A9000R,DS8880系列,以及V7000F/V5030F。

EMC

全闪存市场的头把交椅是给EMC坐的,占整体市场份额的最高,当然,EM不止C提供一条闪存产品线。全闪存产品有高端全闪存VMAX AFA。Unity F系列,EMC Unity的性能是EMC前一代VNX阵列的3倍,可提供高达30万 IOPS。

EMC 收购了XtremIO, XtremIO 是一种分布式架构, XtremIO存储阵列是一个全闪存系统,以横向扩展体系结构为基础。系统采用了称为X-Brick的构造块,这些构造块可以群集化,以按照需要来提高性能和容量。

HPE惠普

惠普(HPE) 3PAR StoreServ 2全闪存阵列,拥有高性能和可扩展性。可优化闪存的架构特性包括用于基于硅的硬件加速的HPE 3PAR Gen5 Thin Express ASIC,内联重删技术,零检测和其它压缩技术。

NetApp

Netapp 有全闪存 FAS A 系列, EF 系列,AFF8000。

SolidFire

是全闪存的Server SAN 架构,去年被Netapp 收购了。

华为

有Dorado全闪存阵列

对于产品的选择需要了解不同存储产品的市场定位同时结合自己公司的应用类型和实际情况来选:

那当下最流行的运存储 全闪存SolidFire 来说,其市场定位和优势场景:

SolidFire是一款基于Server SAN架构的AFA分布式存储,其有清晰明确的市场定位。 其主要定位就在块block协议,不提供file和object对象功能。其主要应用案例和场景,7成用来和云opentask,VM集成,2成用在轻量级数据库比如mongoDB,PG,MySQL等,1成用来IOPS 2W左右的物理机。并且其核心设计里理念就是云里面保证qos--单个host提供有限的IO,其架构不适用于高吞吐带宽类应用。 其优势就是用丰富的API,和Opentask、云集成比较好,是devops的最爱。不适合传统集中型IO密集大型高性能数据库应用,也不适合存储大量图片、视频、归档等互联网带宽型应用。

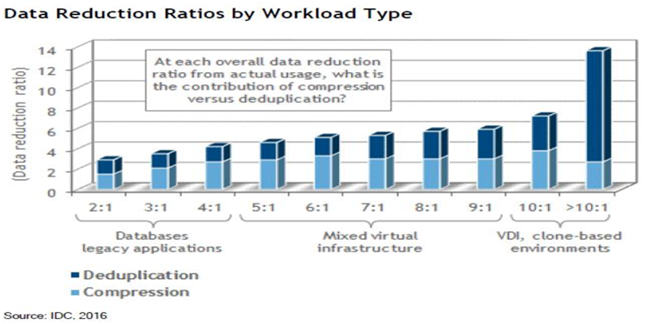

相比其他Server SAN存储,SolidFire 另一个优势是其具备较完善的存储软件功能。(虽然在诸如一致性快速卷的数量等方面有很大限制。)支持压缩去重功能,可以有效的改善使用全SSD带来的成本问题。

再说说IBM 最高端FLASH闪存式A9000R: XIV的网格软件技术结合FlashSystem的硬件闪存是一个最佳的组合造出了A9000R。经过TMS和XIV的跨国合作(XIV是2008年收购的以色列公司),休斯顿和特拉维夫的研发人员飞越大西洋和地中海,紧密合作,终于诞生了A9000这个产品。一个满配的A9000R占用42U,有6组Grid 组合,每个Grid组合 包含2个Interface node 和一个FlashSystem磁盘阵列。一同组成一套网格分布式存储系统。A9000R在压缩去重效果相比其他厂商和Server SAN好很多,数据节约率最高,同时能保证极致性能。

A9000R 的极大优势在于其传承与XIV 的软件定义网格分布式架构,同时再存储复制解决方案上可以和XIV 完全兼容。相比传统厂商的AFA 要领先很多。

核心议题- AFA(All Flash Array)全闪存阵列与软件定义分布式Server SAN 全闪存有什么区别?各自适用环境?

王天恩 项目经理 电信系统集成

1、软件架构不一样,全闪阵列就那IBM F900来讲是基于FPGA架构,传输的速度和存储介质类型都很不错,其主要的应用场景是传统应用对IO响应速度要求高的,如金融和互联网行业比较多;

2、软件定义分布式的全闪存是基于分布式架构的,通过分布式软件将多台X86形成了一个逻辑整体,其存储介质类型是常见的SSD,其主要应用场景是新兴的云化的应用、云计算场景中比较多;

wangshuai_go 存储工程师 平安科技

那当下最流行的云存储全闪存SolidFire 来说,其市场定位和优势场景:

SolidFire是一款基于Server SAN架构的AFA分布式存储,其有清晰明确的市场定位。 其主要定位就在块block协议,不提供file和object对象功能。其主要应用案例和场景,7成用来和云opentask,VM集成,2成用在轻量级数据库比如mongoDB,PG,MySQL等,1成用来IOPS 2W左右的物理机。并且其核心设计里理念就是云里面保证qos--单个host提供有限的IO,其架构不适用于高吞吐带宽类应用。 其优势就是用丰富的API,和Opentask、云集成比较好,是devops的最爱。不适合传统集中型IO密集大型高性能数据库应用,也不适合存储大量图片、视频、归档等高带宽型应用。

相比其他Server SAN存储,SolidFire 另一个优势是其具备较完善的存储软件功能。(虽然在诸如一致性快速卷的数量等方面有很大限制。)支持压缩去重功能,可以有效的改善使用全SSD带来的成本问题。

再说说IBM 最高端FLASH闪存式A9000R: XIV的网格软件技术结合FlashSystem的硬件闪存是一个最佳的组合造出了A9000R。经过TMS和XIV的跨国合作(XIV是2008年收购的以色列公司),休斯顿和特拉维夫的研发人员飞越大西洋和地中海,紧密合作,终于诞生了A9000这个产品。一个满配的A9000R占用42U,有6组Grid 组合,每个Grid组合 包含2个Interface node 和一个FlashSystem磁盘阵列。一同组成一套网格分布式存储系统。A9000R在压缩去重效果相比其他厂商和Server SAN好很多,数据节约率最高,同时能保证极致性能。

A9000R 的极大优势在于其传承与XIV 的软件定义网格分布式架构,同时再存储复制解决方案上可以和XIV 完全兼容。相比传统厂商的AFA 要领先很多。

以上两款全闪存都是分布式架构的,其是基于全闪存而重新设计了整个系统和架构,目的就是为了完全的匹配和契合闪存介质的高性能。

再说说传统存储升级为全闪存的情况。传统厂商比如HP 的3par 升级之后推出基于3par 的全闪存阵列,比如EMC 升级VNX 之后推出基于unity F全闪存,VMAX 升级后推出VMAX AFA。 他们都有一个共同特点,就就是在已有传统存储架构上升级改造来的。而像SolidFire 和A9000R 是为了全闪存而重新设计存储架构。 当然传统存储升级为全闪存也有他的优点,比如说继承了传统存储的全部优点,解决方案成熟、稳定等,传统HDD存储能上的场景他们都能上。缺点也很明显就是其架构是前一代存储改造升级来的,不够彻底。

韩斐 技术经理 汉中供电局

传统厂商比如HP 的3par 升级之后推出基于3par 的全闪存阵列,比如EMC 升级VNX 之后推出基于unity F全闪存,VMAX 升级后推出VMAX AFA。 他们都有一个共同特点,就就是在已有传统存储架构上升级改造来的。而像SolidFire 和A9000R 是为了全闪存而重新设计存储架构。 当然传统存储升级为全闪存也有他的优点,比如说继承了传统存储的全部优点,解决方案成熟、稳定等,传统HDD存储能上的场景他们都能上。缺点也很明显就是其架构是前一代存储改造升级来的,不够彻底。

核心议题-云时代全闪存存储组织架构选择—超级融合(hyperconvergence)还是超大规模(Hyperscale)?

wangshuai_go 存储工程师 平安科技

其实这个问题不单单适用于全闪存。更多的是探讨未来数据中心存储架构选择问题。

首先明说明以融合hyperconvergence、大规模Hyperscale定义等名词定义:

- 融合:扩展架构的服务器、存储、网络、虚拟化/集装箱式组件捆绑在一起作为一个预测试、预集成的解决方案。在这种体系结构中,组件仍然是不同的。

- 超级融合的:扩展的架构朝着融合基础设施更进一步,通过将软件定义的组件与商品化的硬件结合,封装成一个单一的解决方案——其通常是一款单一的设备。组件不再是不同的。

- 超大规模:规模扩展的架构,同时也是软件定义和商品化的,但其服务器、存储、网络、虚拟化/集装箱式资源仍然是保持独立的。每个组件是不同的,可以独立缩放。

综上所述,超级融合的基础设施是现代化的、合乎极端逻辑的融合系统;而超大规模则是现代化的、合乎极端逻辑的我们已经部署了30年的数据中心的方式。两者在特定的环境下都有其意义。

未来数据中心存储架构是选择超大规模或超融合?

超融合可以是更简单,更具成本效益的方法。个人更倾向中小规模数据中心用hyperconvergence超融合架构,成本低。

大规模数据中心采用hyperscale超大规模架构--存储和计算分离的解耦合架构。为什么呢?因为当部其基础设施架构的时候,很多时候更倾向于灵活性(或敏捷,如果您一定要使用该术语的话)要高于一切。

一套超融合的系统提供了一个简化的类似于“搭积木”的方法来构建IT。对于那些正在寻求降低部署的开销,并扩大其云基础设施的精益IT组织而言,超融合提供了一个良好的解决方案。但其需要一套相对可预测的工作负载,在“数据本地化”是一个首要任务,这意味着应用程序或虚拟机必须尽可能的接近数据。这就是为什么VDI 会成为超融合的一个典型代表的原因所在了。用户希望自己的“虚拟C:驱动器”本地化。但这是不灵活的,因为其涉及所有元素的同步缩放。

一款超大规模的系统保持存储独立计算,从而使得企业能够在其业务需要时规模化其IT能力。数据中心和云基础设施的超大规模的方法提供了一种高水平的弹性,帮助企业能够快速响应不断变化的应用程序和数据存储需求。这也是一款类似于Hadoop和NoSQL、以及类似于OpenStack和Docker等云平台架构的更符合现代工作负载的架构。所有这些都是从独立的规模化缩放共享存储受益的分布式系统的例子。

像亚马逊、谷歌和Facebook这些互联网企业都是超大规模数据中心。保持灵活性和可扩展性最重要,其存储架构都是采用超大规模(Hyperscale)即存储和计算分离的部署模式。这对传统公司来说也是很好的借鉴意义。

核心议题-什么是全闪存存储架构?全闪存存储架构有什么优点?

聂奎甲 项目经理 长春长信华天

全闪存存储架构是以全闪存阵列做为存储设备用以存取数据,在整体性能上要比传统磁盘阵列快。

ibmfuqiang 系统架构师 IBM

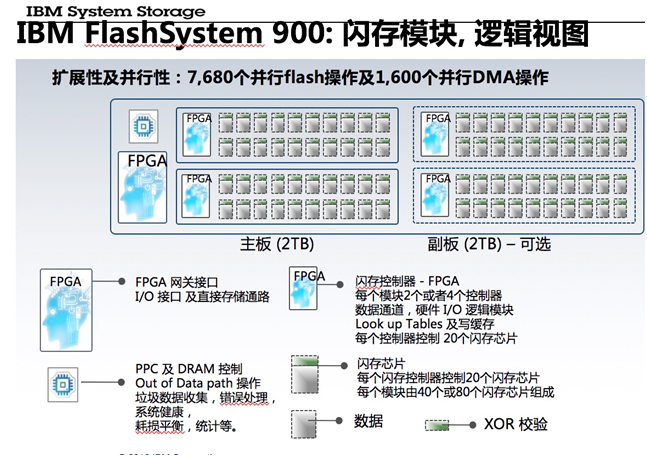

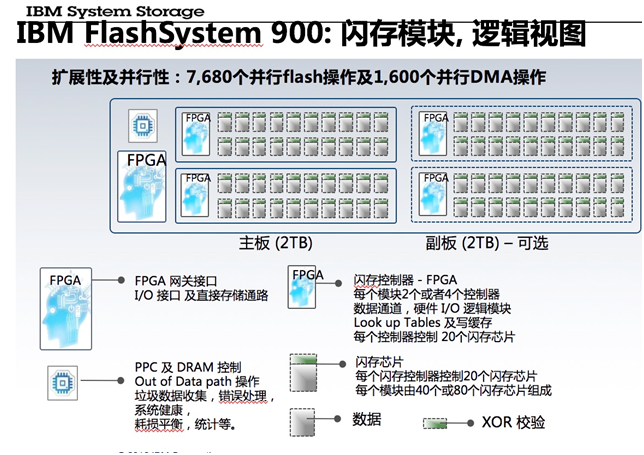

首先业内很多厂家并不是全闪存的构架设计,ibm的 flash900, v9000,A9000/9000R是采用全闪存构架的。IBM全闪的微延迟模块核心设计如下图:

IBM 全闪存存储的优势,主要有下面三点:

我们将着重向您介绍 FlashCore 技术 - 这些基本元素有助于我们实现可靠性、密度和性能特征。我们这里谈论的内容包括:

1)硬件加速的 IO - 也就是说,当数据进入 FlashSystem 机箱时,数据路径中没有管理所有数据的典型处理器或软件。所有数据都借助 FPGA(现场可编程逻辑闸阵列)进行硬件加速,这可帮助我们提供极低的延迟。

2),我们还谈论了 IBM MicroLatency 模块 - 即我们与竞争性全闪存解决方案中的商品/成品 SSD 进行比较的实际闪存模块。我们已设计和构建机箱,以支持单个闪存芯片的性能。

3),我们还谈论了高级闪存管理 -包括我们连同 IBM 研究院所做的工作。在 IBM 研究院中,我们已经开发了强大的闪存磨损管理等专利的技术,帮助我们提高了解决方案的耐磨性。

FlashCore 技术是 FlashSystem 系列的核心,它的性能、可靠性和密度优势遍及整个产品系列。

核心议题-全闪存与传统存储如何共用?

聂奎甲 项目经理 长春长信华天

全闪存可以用在对性能要求较高的生产系统上,或是采用IBM SVC分级存储,全闪存做为在线存储,传统存储用于离线存储或是归档备份用。

wangshuai_go 存储工程师 平安科技

我感觉这个问题改成SSD存储和HDD存储如何共用应该更好。

传统存储厂商都推出了SSA(solid state arrary) 全闪存阵列,传统存储闪存化大趋势早已经确定。IBM,HPE,EMC,HUAWEI,这些存储厂商如果不主推全闪存存储,都不好意思出来见人。

数据库等IOPS和延迟 IO性能 需求高的应用可以迁移网全闪存。鉴于目前全闪存价格依据高昂,视频,归档等要求容量需求为主,但是IOPS 和延迟不敏感同时注重成本的应用可以在近几年依据采用HDD存储。

2017 SSA 全闪存阵列魔力象限排名。 可以看到主流存储厂商Pure Storage, Dell EMC, IBM ,HEP NetAPP, HDS等均有上榜。 现在HDD 排名和混合阵列排名依据不流行到了没人看的地步了。

ibmfuqiang 系统架构师 IBM

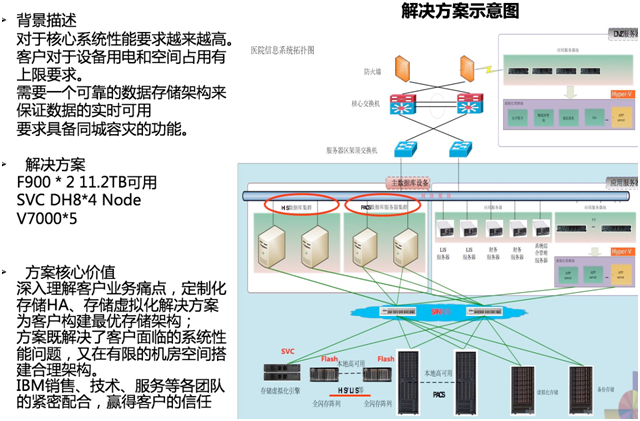

这种场景其实很多,ibm也错了很多个类似的成功案例,主要集中在金融,保险,银行,医院,企业,政府,制造等。简单来说,对性能要求较高的业务可以把放在全闪存储上,对性能要求一般或者不高的放在传统磁盘存储上,至于如何利旧,可以在上面封装一个虚拟存储层svc来发表实现,如下图所示:某医院HIS/PACS 等综合系统大集中案例:

核心议题-全闪存就一定贵吗--全闪存vs机械盘 成本分析对比讨论?

wangshuai_go 存储工程师 平安科技

我司全闪存TCO成本低的秘诀之所在

我司通过Thin、压缩、去重、高密度机架等技术全面降低全闪存TCO使用成本:

基本做到核心生产系统SSD “GB/成本”接近于传统高端HDD存储。

做到容灾系统SSD “GB/成本”接近于传统高端HDD存储的60%-90%。

高性能测试和高性能报表库SSD “GB/成本”接近传统高端存储的50%-80%。

VDI ,虚拟机场景SSD “GB/成本”接近中端存储价格。

以A9000R分布式全闪存为例介绍压缩、去重技术

现在的存储厂商如果卖个客户的全闪存存储,不标配压缩、去重功能就不好意思出来见人。比较闪存还是太贵了,不支持压缩去重成本太高,大多数企业都用不起的。比如物理容量100TB的全闪存在A9000R存储上可以提供200-500TB的可用容量,成本就大幅降下来了。

辛旻讲IT 全球领先的IT服务平台

不一定,合理规划设计,参见拙作

核心议题-企业上全闪存架构的风险评估?

聂奎甲 项目经理 长春长信华天

很多客户都面临这个问题,目前IBM可以提供一系列的数据迁移解决方案,可以咨询IBM

ibmfuqiang 系统架构师 IBM

其实企业上全闪存和更新换代一个传统的存储风险是一样的,并不会因为上全闪就是风险变高。可以合理设计,比如利用ibm svc配合着全闪flash 900(或者直接配置flash v9000),发挥svc的在线数据迁移技术,可以很好的控制风险,在线迁移生产数据(当然客户的重要数据在迁移之前一定要做好备份),利用svc广泛支持异构存储虚拟化特性可以很好的链接全闪与传统磁盘阵列协调工作,又可以很多的利旧为客户投资保护。

wuwenpin 软件开发工程师 南京南瑞

慎重选择!

议题- SSD 充当 HDD 缓存的技术,为什么没有被广泛运用?

wangshuai_go 存储工程师 平安科技

SSD 充当 HDD 缓存的技术 当下在Server SAN中被广泛应用。目的就是为了用SSD 来缓存加速提升整个系统的IOPS 和降低延迟,同时兼具成本考虑。SSD 充当 HDD 缓存的技术是个过渡方案,未来如果SSD 价格一再下降,这个方案成本优势就不明显了。

议题-全闪存存储架构设计中所使用到的主要技术有哪些?

聂奎甲 项目经理 长春长信华天

可以说每个厂商的全闪存阵列产品都有其华丽之处,通过近期的实际场内测试,对IBM的Flash System系列全闪存阵列的感触比较深。首先业内大多数全闪存阵列基本是采用X86架构的控制器,只是针对闪存对代码进行一定的优化,另外闪存介质也是SAS封装的SSD,而IBM的FS系列全闪存阵列采用平地而起的控制器架构设计、全硬件数据链路,以及PCIe形态的闪存卡,这些技术都充分保证了闪存介质的性能发挥而不会带来额外的协议转换和IO处理效率的开销。另外FS V系列实现了全闪存阵列和SVC的有机融合,从而提供更丰富的软件功能,可以更好的和现有存储架构高效融合。

ibmfuqiang 系统架构师 IBM

其实可以不谦虚的说ibm flashsystem是真正的全闪存构架设计,市场上其他厂家90%的都是ssd封装的磁盘阵列传统构架设计。 说到为什么ibm flash会更优,更快,更稳。究其根本是因为IBM 采用了独有的专利技术flash core核心技术,主要概括为以下三方面:

FlashCore 技术 - 这些基本元素有助于我们实现可靠性、密度和性能特征。我们这里谈论的内容包括:

1,硬件加速的 IO - 也就是说,当数据进入 FlashSystem 机箱时,数据路径中没有管理所有数据的典型处理器或软件。所有数据都借助 FPGA(现场可编程逻辑闸阵列)进行硬件加速,这可帮助我们提供极低的延迟。

2,IBM MicroLatency 微延迟模块 - 即我们与竞争性全闪存解决方案中的商品/成品 SSD 进行比较的实际闪存模块。我们已设计和构建机箱,以支持单个闪存芯片的性能。

3,我们还谈论了高级闪存管理 -包括我们连同 IBM 研究院所做的工作。在 IBM 研究院中,我们已经开发了强大的闪存磨损管理等技术,帮助我们提高了解决方案的耐磨性, 并含有很多专利技术在里面。

FlashCore 技术是 FlashSystem 系列的核心,它的性能、可靠性和密度优势遍及整个产品系列。

议题-在云时代,金融行业存储技术全闪存存储该如何架构?

聂奎甲 项目经理 长春长信华天

对于全闪存存储来说,目前价格在逐渐降低,单TB成本已经接近于传统存储。

对于自动分层技术,目前全闪存存储已经全部都具备了,一些高级功能传统存有的,目前全闪存阵列也都具备。

在设备选型时候,建议用户选择混合全闪存阵列。在配置硬盘时候,按照不同的业务需求配置不同类型的硬盘,即能提高性能,有能够降低成本。

ibmfuqiang 系统架构师 IBM

我认为金融行业在应对云计算时代到来,要合理规划合理设计合理应对,一些重要的核心的业务可以考虑继续使用传统存储构架设计,其中使用全闪存是必不可少的,针对一些外围系统业务,可以考虑分布式存储或者云对象存储,更加灵活多变的构架设计。

韩斐 技术经理 汉中供电局

要合理规划合理设计合理应对,一些重要的核心的业务可以考虑继续使用传统存储构架设计,其中使用全闪存是必不可少的,针对一些外围系统业务,可以考虑分布式存储或者云对象存储.成本控制很重要。

议题-全闪阵列的基本架构是什么?

聂奎甲 项目经理 长春长信华天

全闪存可以用在对性能要求较高的生产系统上,或是采用IBM SVC分级存储,全闪存做为在线存储,传统存储用于离线存储或是归档备份用。

ibmfuqiang 系统架构师 IBM

关于全闪存的构架,其他厂商采用的ssd固态盘阵列我想就不必多说了,大家都很清楚。ibm flashsystem全闪存模块内部解析,我给大家呈现一下,它的不同设计:

可见:每个模块2个或者4个控制器数据通道,硬件 I/O 逻辑模块Look up Tables 及写缓存每个控制器控制 20个闪存芯片;每个闪存控制器控制20个闪存芯片每个模块由40个或80个闪存芯片组成。

值得思考的是:FPGA在执行运算的时候是更优更高效的。原因在于:

FPGA:

与CPU控制不同的是:它的逻辑是硬件可编程的,而CPU则需要通过操作系统及软件编程来执行相应的计算,和专用集成电路(ASIC)相比,它相当于一种半成品式的逻辑芯片,即:FPGA是一个可随意硬定制的内部逻辑阵列。

在Flash的数据处理路径上,FPGA是通过硬件编程来获得,即:以内部的不同门电路的硬逻辑组合实现类似软件的算法,因此这种“电路直给”似的数据路径算法在执行效率上大幅度提高!

议题-全闪存存储如何设计容灾方案?

聂奎甲 项目经理 长春长信华天

例如v9000全闪存阵列本身自带svc的高级软件功能可以实现容灾,例同步复制和异步复制。

ibmfuqiang 系统架构师 IBM

存储容灾必定离不开各个厂家存储产品的数据复制同步技术,各家大同小异。ibm的svc是存储虚拟化领域里面的佼佼者,其复制功能也很强大,如下,仅供参考:

1)复制种类:

同步复制(Metro Mirror)

异步复制(Global Mirror)

差量复制(Global Mirror with Change Volume)

双活技术(Hyper swap – Enhance Stretch System)

2)复制方式:

基于FC的复制

基于IP的复制

议题- ssd盘有必要raid10吗?我觉得raid1就很好了?

辛旻讲IT 全球领先的IT服务平台

有必要

wangshuai_go 存储工程师 平安科技

同样楼上观点,是很有必要的。为什么?

- SSD 是非常快,但是单个SSD 的性能还是有限的,IOPS 是可以跑的很高,但是带宽是限制死的。

- 现在的存储软件算法都是POOL化的。即数据进入系统会切成固定大小的数据块,然后随机分布到所有的节点,所有硬盘,避免热点问题,同时提升系统性能和可靠性。

wuwenpin 软件开发工程师 南京南瑞

不同的技术,只有适合的,没有最好的。

议题-超融合和传统虚拟化有什么相比有什么缺点?

wangshuai_go 存储工程师 平安科技

融合:扩展架构的服务器、存储、网络、虚拟化/集装箱式组件捆绑在一起作为一个预测试、预集成的解决方案。在这种体系结构中,组件仍然是不同的。

超级融合的:扩展的架构朝着融合基础设施更进一步,通过将软件定义的组件与商品化的硬件结合,封装成一个单一的解决方案——其通常是一款单一的设备。组件不再是不同的。

一套超融合的系统提供了一个简化的类似于“搭积木”的方法来构建IT。对于那些正在寻求降低部署的开销,并扩大其云基础设施的精益IT组织而言,超融合提供了一个良好的解决方案。但其需要一套相对可预测的工作负载,在“数据本地化”是一个首要任务,这意味着应用程序或虚拟机必须尽可能的接近数据。这就是为什么VDI 会成为超融合的一个典型代表的原因所在了。用户希望自己的“虚拟C:驱动器”本地化。但这是不灵活的,因为其涉及所有元素的同步缩放。

但是超融合存储架构也有其明显的缺点,特别是在大规模数据中心使用场景。比如说,你公司IT增持需求计算资源每年是增长1倍,但是存储容量需求是每年增长10倍。此时你用超融合架构就很不划算了,为啥呢?因为你为了那10倍的容量增长买了超融合硬件后发现还有9倍的计算资源浪费了。 反正计算需求增长10倍,但是存储增长5倍,那么你就有5倍的存储资源浪费了。

而采用传统SVC虚拟化则没有这个浪费的问题,因为存储和计算是解耦合,存储和计算各自可以单独扩容。灵活性大大提升。

没有像亚马逊、谷歌和Faceboo这些大规模IT企业。都是采用计算和存储分离的架构,以便能够降低成本,并同时保持灵活性和可扩展性,以跟上业务发展的需求。

议题-主机连光纤再连阵列和主机hba卡直连阵列哪种方式好?

聂奎甲 项目经理 长春长信华天

1.并不是所有的主机都能直接连接阵列,有些必须使用光纤交换机

2.主机通过光纤通道卡更易于管理的增强灵活性。

peterzhu 系统工程师 Nanjing Digital China Limited

主要还是看现场环境的复杂度,如果只有一两台主机连接一台存储,确认今后三五年内也不会有针对存储使用的IT设备增加,那就直连吧,简单高效(前提是存储支持直连,以前IBM V系列存储由于微码级别低且提供存储虚拟化功能,不支持直连)。

如果IT环境复杂,针对存储的需求较多,此次需要通过光交来实现,毕竟存储的主机接口是有限的。

光交的就是起个牵线搭桥的作用,对性能的影响目前并不明显,但是随着IT设备逐步更新换代,针对原有2GB/4GB/主流8GB/目前16GB等接口的兼容性问题,会逐步显现,彼时对性能有无影响,暂时还不好说。

关于你担心的故障点问题,可以理解,所以一般都建议光交配置两台,形成冗余。

wuwenpin 软件开发工程师 南京南瑞

大系统一般用HBA卡链接。

议题-存储数据的未来趋势使企业存储面临怎样问题?

聂奎甲 项目经理 长春长信华天

今天的存储采购要支持的业务系统,未来几年很可能会变成私有云或者干脆上公有云;今天的存储采购只需要100块磁盘的配置,但是随着业务发展,很可能要变成上千块磁盘的规模;今天的闪存还很贵所以只能小范围应用,随着闪存价格和容量的改进,未来几年要大面积更换介质;今天的数据存储都集中在核心数据中心,但是未来因为数据分析的需要,可能要在全国建设几十上百个小型数据中心或者专用系统等等。

这些问题让企业的存储采购和架构设计变得非常困难。利用svc的存储虚拟化功能,不论任何厂商,任何架构,任何介质,任何地点,甚至任何公有云和私有云,都可以把所有的存储资源打通并进行统一管理。只有这样的管理架构才能应对未来如洪水般涌来的数据的挑战。而用户在架构设计、设备采购、介质选择以及向公有云迁移的策略和实施上,将获得无以伦比的自由度和弹性。

企业存储需求日益复杂,而且随着业务需求和存储技术的不断变化,企业存储在制定策略时必然要面对越来越多的不确定性。

议题-存储底层备份与存储网关的优缺点?

wangshuai_go 存储工程师 平安科技

这个问题问的不是很清楚。我根据我的理解来回答一下。

这里的存储网关是否指的是SVC/Vplex 存储虚拟化网关,存储底层备份是否指的基于传统存储的备份解决方案。

如果是的那么我根据我理解回答一下。

基于传统存储的备份解决有比如说对原来生产卷做快照,将快照挂着起来做备份的。

SVC网关也是这么用。但是新版的SVC 网关已经支持直接将快照通过S3 直接复制到云对象存储上完成数据的备份。

我认为SVC虚拟化网关相比传统存储的主要优势就是在软件解决方案方面。

如果觉得我的文章对您有用,请点赞。您的支持将鼓励我继续创作!

赞10本文隶属于专栏

作者其他文章

评论 2 · 赞 7

评论 6 · 赞 8

评论 0 · 赞 1

评论 0 · 赞 9

评论 0 · 赞 6

添加新评论1 条评论

2018-06-30 19:26